StoryMem

Narration Vidéo Longue Multi-plans avec Mémoire

De la "génération aléatoire" à la "pensée de réalisateur". Grâce à des banques de mémoire visuelle explicites et à la technologie de décalage RoPE négatif, StoryMem résout le problème de "l'oubli" dans la narration multi-plans, atteignant une cohérence inter-plans de niveau cinématographique.

Percées Fondamentales & Évolution

La "Troisième Voie" de la Technologie de Génération Vidéo

Point Douloureux Principal : "L'Oubli" Multi-plans

Les modèles DiT existants traitent chaque génération comme un processus aléatoire indépendant. Lors du passage d'un "plan large" à un "gros plan", les caractéristiques au niveau du pixel (coiffure, texture des vêtements) mutent souvent, brisant l'immersion.

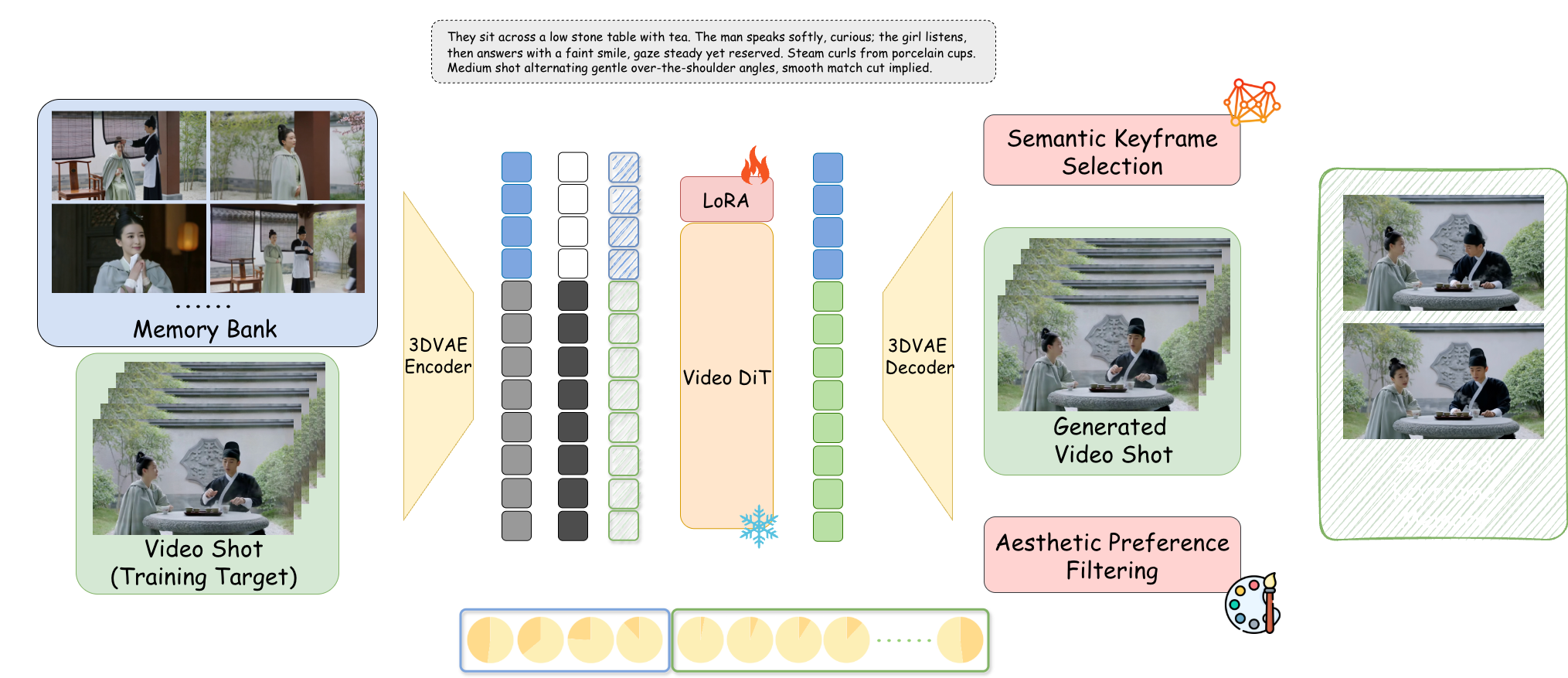

Banque de Mémoire Explicite

Au-delà de la modélisation conjointe gourmande en calcul et de l'auto-régression simple. StoryMem établit un module de mémoire dynamique indépendant du processus de génération, maintenant le contexte narratif comme la mémoire de travail humaine.

Décalage RoPE Négatif

Singularité Technologique : En attribuant des indices temporels négatifs aux images mémoire, il crée un mécanisme d'attention "sémantiquement connecté mais spatio-temporellement déconnecté". Simule parfaitement les coupes franches (Hard Cut) de film, conservant l'identité tout en réinitialisant le mouvement.

Plongée dans l'Architecture M2V

Construction de la Banque de Mémoire

Basé sur le réglage fin Wan2.2-I2V + LoRA. Utilise un mécanisme de filtrage intelligent pour ne conserver que les images clés des 10 derniers plans actifs, simulant la "mémoire de travail" humaine pour éviter l'épuisement de la VRAM.

Sélection Sémantique d'Images Clés

Introduit le modèle CLIP pour calculer la similarité cosinus. Ne stocke que les images reflétant le mieux les descriptions actuelles du scénario (ex : "expression en colère"), écartant les images intermédiaires floues ou avec clignement des yeux.

Filtrage de Préférence Esthétique

Intègre le modèle de notation HPSv3 comme "Directeur Artistique IA". Filtre les images effondrées en temps réel, assurant que seul le matériel de haute qualité esthétique reste en mémoire.

Concaténation d'Espace Latent

Les images mémoire sont compressées en Latents via VAE 3D, concaténées avec les vecteurs de bruit actuels dans la dimension du canal, et injectées via un adaptateur LoRA Rank=128.

Évaluation Faisant Autorité ST-Bench

Évaluation quantitative basée sur 300 prompts narratifs multi-plans

Basé sur le calcul de similarité cosinus ViCLIP, quantifiant précisément la capacité de rétention de l'identité du protagoniste.

Score du prédicteur esthétique LAION, prouvant que le module de mémoire n'a pas dégradé les standards artistiques.

Le mécanisme de mémoire n'a pas interféré avec la compréhension des nouvelles instructions par le modèle, répondant précisément aux changements de scénario.

Narration Script-vidéo (Script-to-Video)

Entrée de script structuré JSON, contrôlez les plans comme un réalisateur

Rêve dans le Pavillon Rouge : Daiyu entre au Manoir

AtmosphericComparaison & Positionnement

Comparé aux modèles comme Open-Sora axés sur la simulation physique, StoryMem se concentre sur la Logique Narrative Cinématographique.

❌ Processus Aléatoire : L'apparence du personnage mute avec les changements de plan, le modèle ne peut maintenir une image cohérente.

✅ Injection de Mémoire : Même sous différents angles et éclairages, les détails structurels (yeux, couleur) restent hautement cohérents.

vs. Sora / Open-Sora

Sora tend à générer une seule longue vidéo continue. StoryMem poursuit des Séquences Narratives composées de plans de 5-10s, s'adaptant aux pipelines de montage professionnels.

vs. AnimateDiff

AnimateDiff excelle dans les boucles stylisées mais crée des transitions morphing lors des "Coupes Franches". StoryMem résout cela parfaitement via RoPE négatif.

vs. IP-Adapter

IP-Adapter dépend d'une seule image de référence, sujet à l'effondrement dans des dynamiques complexes. La banque de mémoire dynamique de StoryMem capture des caractéristiques multi-angles.

StoryMem prouve que la "Mémoire" est la clé pour réaliser une narration intelligente avancée. Bien qu'actuellement limité par la qualité du modèle de base (ex: détails des mains) et les coûts de VRAM (24Go recommandés), il ouvre la porte aux "Studios de Cinéma Unipersonnels".

Perspectives Futures : Introduction de Banques de Mémoire Audio pour la cohérence vocale ; exploration des possibilités de génération infinie pour Films Interactifs & Jeux avec rendu temps réel.

📄 Lire le Papier Complet (ArXiv)