StoryMem

Multi-Shot Langvideo-Storytelling mit Gedächtnis

Von "zufälliger Generierung" zu "Regisseur-Denken". Durch explizite visuelle Gedächtnisbanken und negative RoPE-Shift-Technologie löst StoryMem das "Vergessens"-Problem beim Multi-Shot-Storytelling und erreicht filmische Konsistenz über verschiedene Einstellungen hinweg.

Kern-Durchbrüche & Evolution

Der "Dritte Weg" der Videogenerierungstechnologie

Kernproblem: Multi-Shot "Vergessen"

Bestehende DiT-Modelle betrachten jede Generierung als unabhängigen Zufallsprozess. Beim Schnitt von "Totale" zu "Nahaufnahme" mutieren Pixel-Eigenschaften (Frisur, Kleidungstextur) oft, was die Immersion bricht.

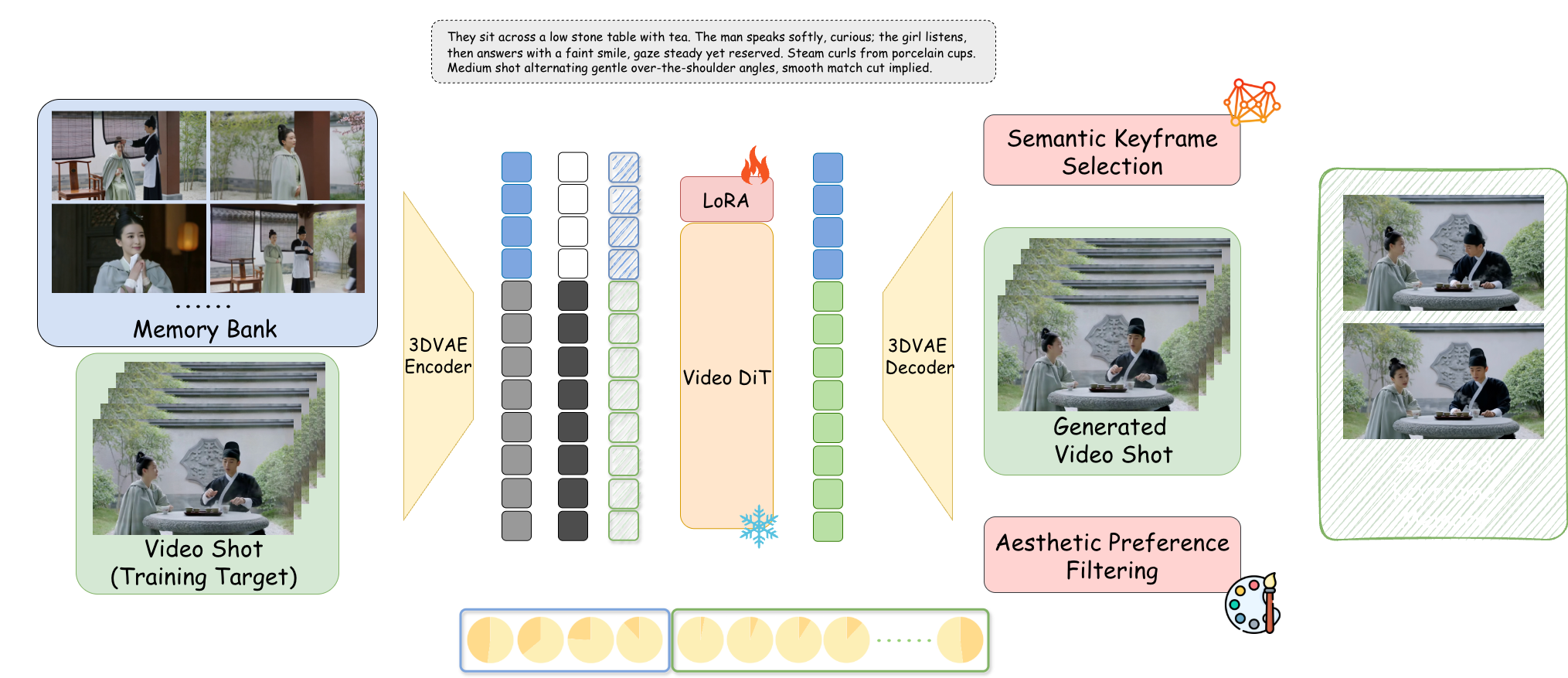

Explizite Gedächtnisbank

Jenseits von rechenintensivem Joint Modeling und einfacher Autoregression. StoryMem etabliert ein dynamisches Gedächtnismodul unabhängig vom Generierungsprozess, das den narrativen Kontext wie das menschliche Arbeitsgedächtnis pflegt.

Negativer RoPE Shift

Technologische Singularität: Durch Zuweisung negativer Zeitindizes zu Gedächtnisframes entsteht ein Aufmerksamkeitsmechanismus, der "semantisch verbunden, aber räumlich-zeitlich getrennt" ist. Simuliert perfekt filmische Hard Cuts, behält Identität bei und setzt Bewegung zurück.

M2V Architektur Deep Dive

Aufbau der Gedächtnisbank

Basierend auf Wan2.2-I2V + LoRA Feinabstimmung. Nutzt intelligenten Filtermechanismus, um nur Keyframes der letzten 10 aktiven Shots zu behalten, imitiert menschliches "Arbeitsgedächtnis" zur Vermeidung von VRAM-Erschöpfung.

Semantische Keyframe-Auswahl

Führt CLIP-Modell zur Berechnung der Kosinus-Ähnlichkeit ein. Speichert nur Frames, die die aktuelle Drehbuchbeschreibung (z.B. "wütender Ausdruck") am besten widerspiegeln, und verwirft unscharfe oder blinzelnde Zwischenframes.

Filterung nach ästhetischer Präferenz

Integriert HPSv3 Scoring-Modell als "KI Art Director". Filtert kollabierte Bilder in Echtzeit heraus und stellt sicher, dass nur Material mit hoher ästhetischer Qualität im Gedächtnis bleibt.

Latent Space Concatenation

Gedächtnisframes werden via 3D VAE zu Latents komprimiert, in der Kanaldimension mit dem aktuellen Rauschvektor verkettet und über Rank=128 LoRA-Adapter in das Modell injiziert.

ST-Bench Autoritative Bewertung

Quantitative Bewertung basierend auf 300 Multi-Shot-Narrativ-Prompts

Basierend auf ViCLIP Kosinus-Ähnlichkeit, quantifiziert genau die Fähigkeit zur Identitätsbewahrung des Protagonisten.

LAION Ästhetik-Prädiktor-Score beweist, dass das Gedächtnismodul den künstlerischen Standard nicht gesenkt hat.

Gedächtnismechanismus stört das Verständnis neuer Anweisungen durch das Modell nicht und reagiert genau auf Drehbuchänderungen.

Drehbuchgesteuertes Storytelling (Script-to-Video)

JSON-strukturierte Drehbueingabe, Szenensteuerung wie ein Regisseur

Traum der Roten Kammer: Daiyu betritt das Anwesen

AtmosphericVergleich & Positionierung

Im Vergleich zu Modellen wie Open-Sora, die sich auf physikalische Simulation konzentrieren, fokussiert StoryMem auf filmische Erzähllogik.

❌ Zufallsprozess: Charakteraussehen mutiert mit Szenenwechsel, Modell kann gleiches Bild nicht halten.

✅ Gedächtnis-Injektion: Selbst unter verschiedenen Winkeln und Lichtverhältnissen bleiben strukturelle Details (Augen, Farbe) hochgradig konsistent.

vs. Sora / Open-Sora

Sora tendiert dazu, einzelne kontinuierliche Langvideos zu generieren. StoryMem strebt nach erzählerischen Sequenzen aus 5-10s Shots, passend für professionelle Filmschnitt-Pipelines.

vs. AnimateDiff

AnimateDiff ist gut in stilisierten Loops, erzeugt aber Morphing-Übergänge bei "Hard Cuts". StoryMem löst dies perfekt durch negativen RoPE.

vs. IP-Adapter

IP-Adapter verlässt sich auf ein einzelnes Referenzbild, anfällig für Zusammenbruch bei komplexer Dynamik. StoryMem's dynamische Gedächtnisbank erfasst Multi-Winkel-Features.

StoryMem beweist, dass "Gedächtnis" der Schlüssel zu fortgeschrittenem intelligentem Storytelling ist. Obwohl derzeit durch die Qualität des Basismodells (z.B. Handdetails) und VRAM-Kosten (24GB empfohlen) begrenzt, öffnet es die Tür zu "Ein-Personen-Filmstudios".

Zukunftsaussicht: Einführung von Audio-Gedächtnisbanken für Stimmkonsistenz; Erforschung unendlicher Generierungsmöglichkeiten für interaktive Filme & Spiele mit Echtzeit-Rendering.

📄 Vollständiges Paper lesen (ArXiv)