StoryMem

带记忆的多镜头长视频叙事

从“随机生成”到“导演思维”。通过显式视觉记忆库与负向 RoPE 偏移技术,StoryMem 解决了多镜头叙事中的“遗忘”难题,实现了电影级的跨镜头一致性。

核心突破与演进

视频生成技术的“第三条道路”

核心痛点:多镜头“遗忘”

现有 DiT 模型视每次生成为独立随机过程。当从“全景”切到“特写”时,虽然语义符合,但像素级特征(发型、服饰纹理)往往发生突变,导致观众沉浸感破裂。

显式记忆库 (Explicit Memory)

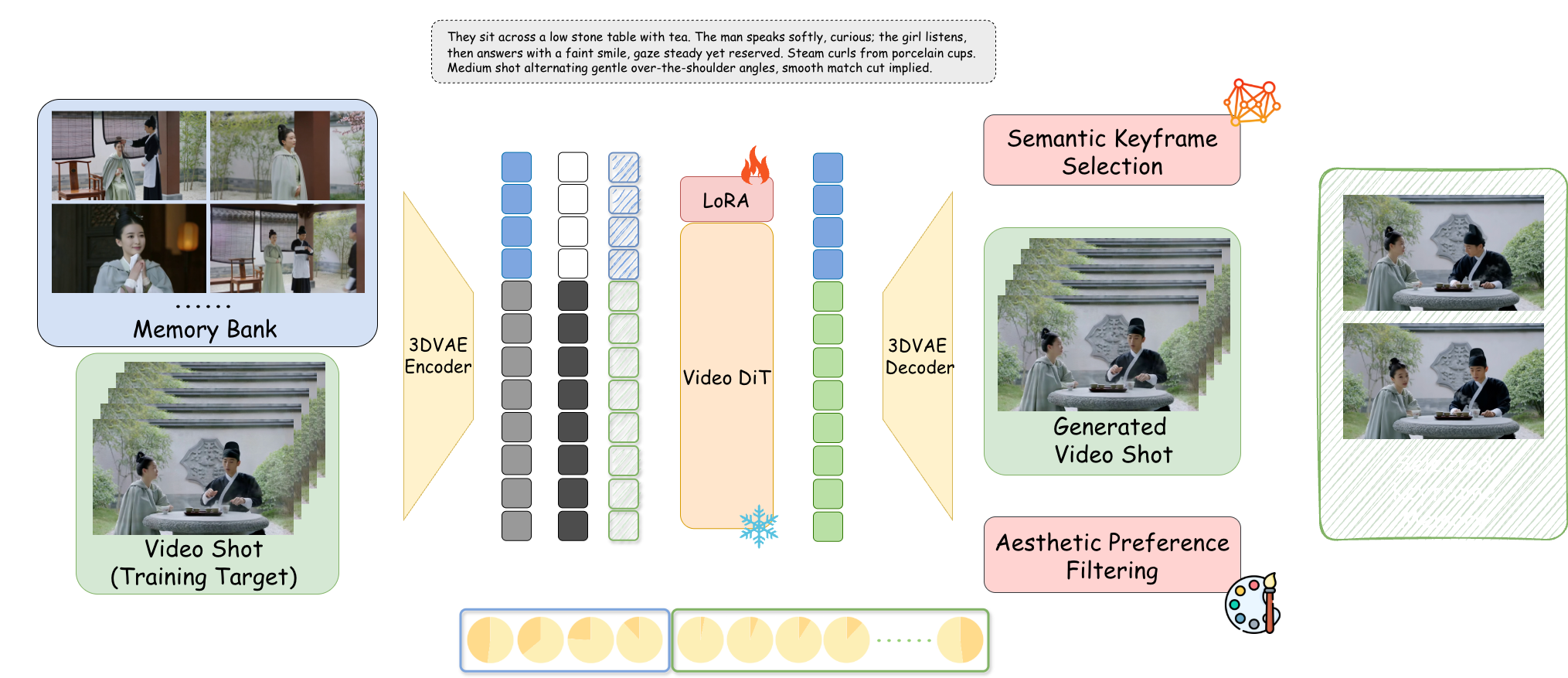

超越高算力的联合建模(Joint Modeling)和简单的自回归。StoryMem 建立独立于生成过程之外的动态记忆模块,像人类工作记忆一样维护叙事语境。

负向 RoPE 偏移

技术奇点:通过赋予记忆帧负向时间索引,创造了一种“语义相连但时空断开”的注意力机制。完美模拟电影硬切(Hard Cut),保留身份特征,重置运动状态。

M2V 架构深度解析

记忆库构建 (Memory Bank)

基于 Wan2.2-I2V + LoRA 微调。采用智能筛选机制,仅保留最近 10 个活跃镜头的关键帧,模拟人类“工作记忆”,避免显存枯竭。

语义关键帧选择

引入 CLIP 模型计算余弦相似度。只存储那些最能准确反映当前剧本描述(如“愤怒的表情”)的帧,剔除模糊或闭眼的中间帧。

美学偏好过滤

集成 HPSv3 评分模型作为“AI 艺术总监”。实时剔除崩坏画面,确保记忆库中仅留存高审美质量的素材。

潜在空间拼接

记忆帧经由 3D VAE 压缩为 Latents,与当前生成的噪声向量在通道维度拼接,通过 Rank=128 的 LoRA 适配器注入模型。

ST-Bench 权威评测

基于 300 个多镜头叙事 Prompt 的量化评估

基于 ViCLIP 余弦相似度计算,准确量化主角身份保持能力。

LAION 美学预测器评分,证明记忆模块未降低艺术水准。

记忆机制未干扰模型对新指令的理解,准确响应剧本变化。

脚本驱动叙事 (Script-to-Video)

JSON 结构化脚本输入,像导演一样控制分镜

红楼梦:黛玉进府

Atmospheric效果对比与定位

相比 Open-Sora 等专注物理模拟的模型,StoryMem 专注于电影叙事逻辑。

❌ 随机过程:角色外观随镜头切换发生突变,模型无法维持同一形象。

✅ 记忆注入:即使在不同角度和光照下,结构细节(眼睛、颜色)保持高度一致。

vs. Sora / Open-Sora

Sora 倾向于生成单条连续长视频。StoryMem 追求由 5-10 秒镜头组成的叙事序列,更符合专业影视剪辑流水线。

vs. AnimateDiff

AnimateDiff 擅长风格化循环,但在处理“硬切(Hard Cut)”时会产生变形过渡。StoryMem 通过负向 RoPE 完美解决此问题。

vs. IP-Adapter

IP-Adapter 依赖单张参考图,在复杂动态中易崩坏。StoryMem 的动态记忆库能捕捉多角度特征,避免僵硬。

StoryMem 证明了“记忆”是实现高级智能叙事的关键。尽管目前受限于基座模型画质(如手部细节)及显存成本(推荐 24GB VRAM),但它开启了“单人电影工作室”的大门。

未来展望:引入音频记忆库实现声纹一致性;结合实时渲染探索交互式电影与游戏的无限生成可能。

📄 阅读论文全文 (ArXiv)