StoryMem

帶記憶的多鏡頭長影片敘事

從「隨機生成」到「導演思維」。通過顯式視覺記憶庫與負向 RoPE 偏移技術,StoryMem 解決了多鏡頭敘事中的「遺忘」難題,實現了電影級的跨鏡頭一致性。

核心突破與演進

影片生成技術的「第三條道路」

核心痛點:多鏡頭「遺忘」

現有 DiT 模型視每次生成為獨立隨機過程。當從「全景」切到「特寫」時,雖然語義符合,但像素級特徵(髮型、服飾紋理)往往發生突變,導致觀眾沉浸感破裂。

顯式記憶庫 (Explicit Memory)

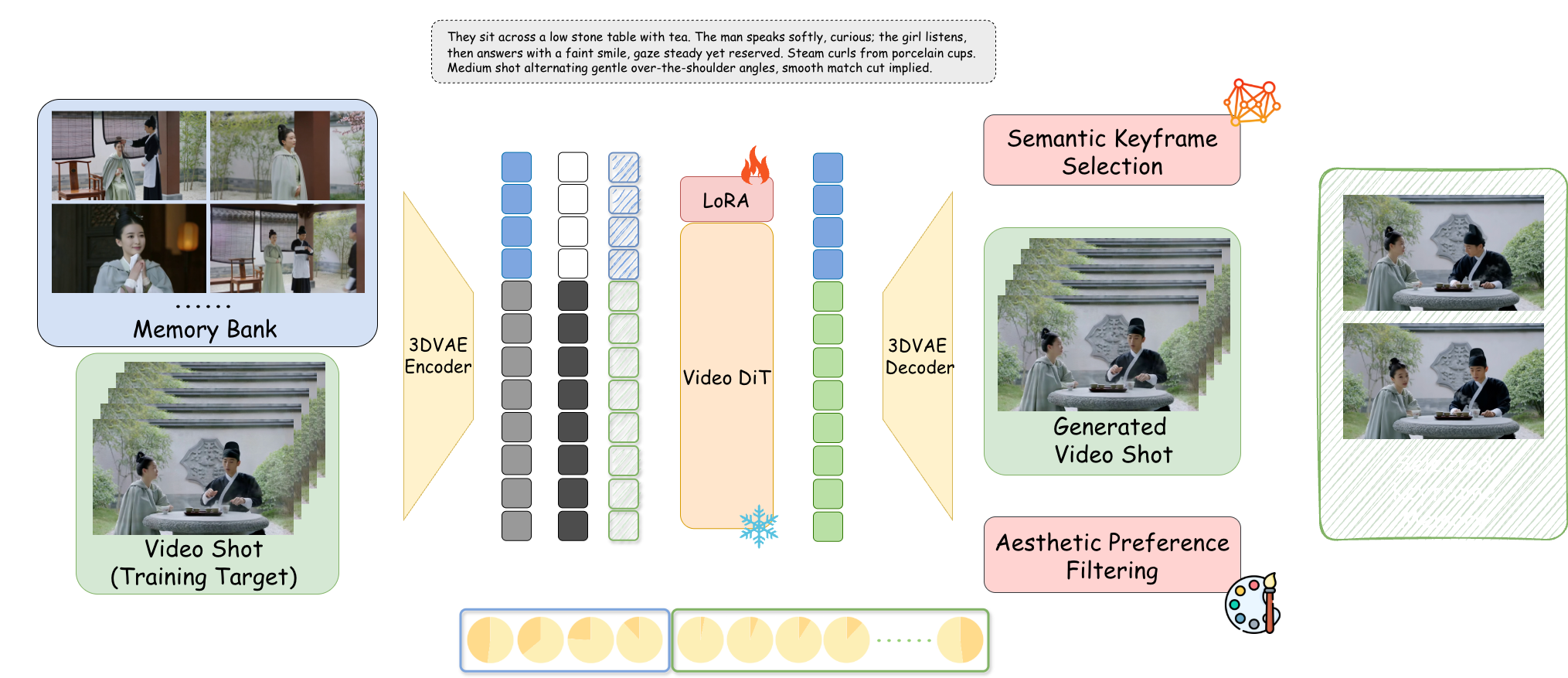

超越高算力的聯合建模(Joint Modeling)和簡單的自回歸。StoryMem 建立獨立於生成過程之外的動態記憶模組,像人類工作記憶一樣維護敘事語境。

負向 RoPE 偏移

技術奇點:通過賦予記憶幀負向時間索引,創造了一種「語義相連但時空斷開」的注意力機制。完美模擬電影硬切(Hard Cut),保留身份特徵,重置運動狀態。

M2V 架構深度解析

記憶庫構建 (Memory Bank)

基於 Wan2.2-I2V + LoRA 微調。採用智能篩選機制,僅保留最近 10 個活躍鏡頭的關鍵幀,模擬人類「工作記憶」,避免顯存枯竭。

語義關鍵幀選擇

引入 CLIP 模型計算餘弦相似度。只存儲那些最能準確反映當前劇本描述(如「憤怒的表情」)的幀,剔除模糊或閉眼的範間幀。

美學偏好過濾

集成 HPSv3 評分模型作為「AI 藝術總監」。實時剔除崩壞畫面,確保記憶庫中僅留存高審美質量的素材。

潛在空間拼接

記憶幀經由 3D VAE 壓縮為 Latents,與當前生成的噪聲向量在通道維度拼接,通過 Rank=128 的 LoRA 適配器注入模型。

ST-Bench 權威評測

基於 300 個多鏡頭敘事 Prompt 的量化評估

基於 ViCLIP 餘弦相似度計算,準確量化主角身份保持能力。

LAION 美學預測器評分,證明記憶模組未降低藝術水準。

記憶機制未干擾模型對新指令的理解,準確響應劇本變化。

腳本驅動敘事 (Script-to-Video)

JSON 結構化腳本輸入,像導演一樣控制分鏡

紅樓夢:黛玉進府

Atmospheric效果對比與定位

相比 Open-Sora 等專注物理模擬的模型,StoryMem 專注於電影敘事邏輯。

❌ 隨機過程:角色外觀隨鏡頭切換發生突變,模型無法維持同一形象。

✅ 記憶注入:即使在不同角度和光照下,結構細節(眼睛、顏色)保持高度一致。

vs. Sora / Open-Sora

Sora 傾向於生成單條連續長影片。StoryMem 追求由 5-10 秒鏡頭組成的敘事序列,更符合專業影視剪輯流水線。

vs. AnimateDiff

AnimateDiff 擅長風格化循環,但在處理「硬切(Hard Cut)」時會產生變形過渡。StoryMem 通過負向 RoPE 完美解決此問題。

vs. IP-Adapter

IP-Adapter 依賴單張參考圖,在複雜動態中易崩壞。StoryMem 的動態記憶庫能捕捉多角度特徵,避免僵硬。

StoryMem 證明了「記憶」是實現高級智能敘事的關鍵。儘管目前受限於基座模型畫質(如手部細節)及顯存成本(推薦 24GB VRAM),但它開啟了「單人電影工作室」的大門。

未來展望:引入音訊記憶庫實現聲紋一致性;結合實時渲染探索互動式電影與遊戲的無限生成可能。

📄 閱讀論文全文 (ArXiv)