StoryMem

Narración de Video Largo Multi-toma con Memoria

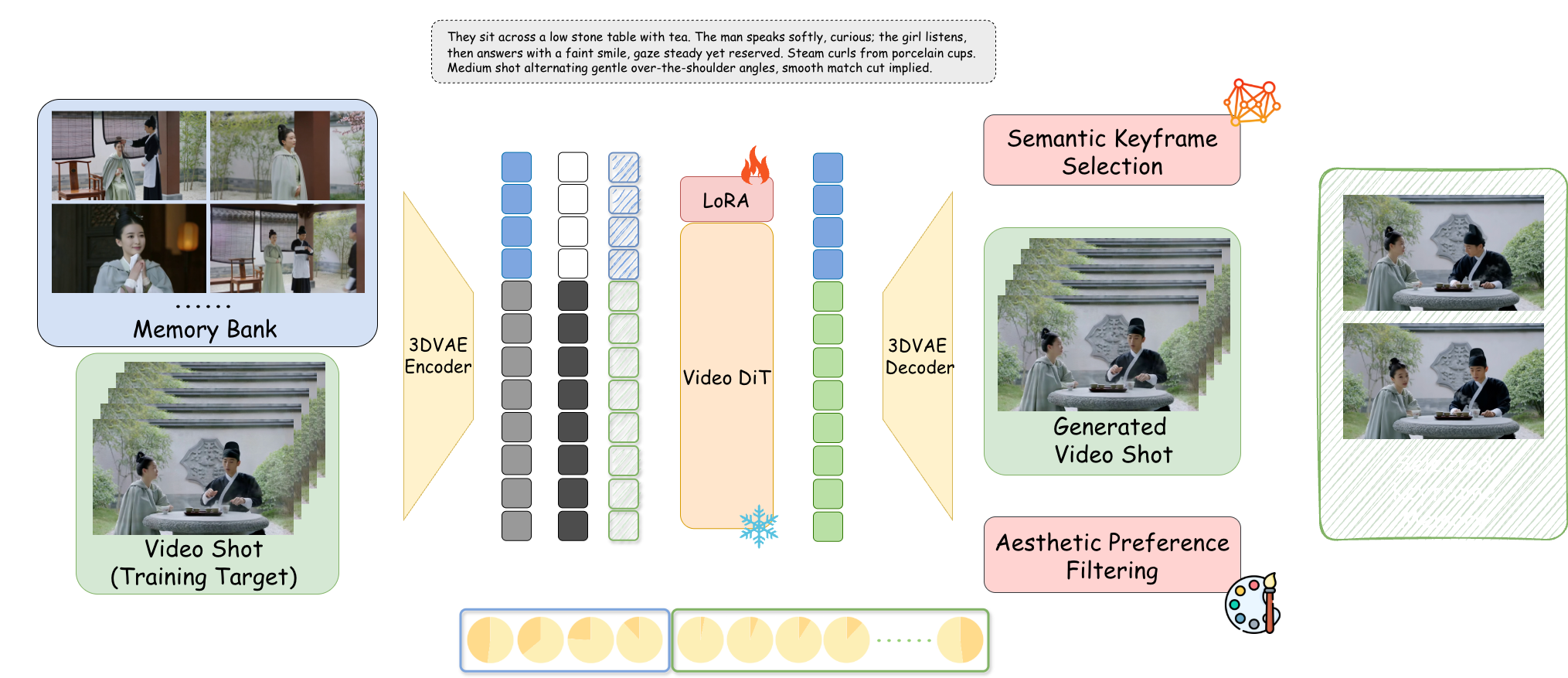

De "generación aleatoria" a "pensamiento de director". A través de Bancos de Memoria Visual Explícitos y tecnología de Desplazamiento RoPE Negativo, StoryMem resuelve el problema del "olvido" en la narración multi-toma, logrando consistencia cinematográfica entre tomas.

Avances Fundamentales y Evolución

La "Tercera Vía" de la Tecnología de Generación de Video

Punto de Dolor Central: "Olvido" Multi-toma

Los modelos DiT existentes tratan cada generación como un proceso aleatorio independiente. Al cortar de "plano general" a "primer plano", las características a nivel de píxel (peinado, textura de ropa) a menudo mutan, rompiendo la inmersión.

Banco de Memoria Explícito

Más allá del Modelado Conjunto de alto cómputo y la simple auto-regresión. StoryMem establece un módulo de memoria dinámico independiente del proceso de generación, manteniendo el contexto narrativo como la memoria de trabajo humana.

Desplazamiento RoPE Negativo

Singularidad Tecnológica: Al asignar índices de tiempo negativos a los cuadros de memoria, crea un mecanismo de atención "semánticamente conectado pero espaciotemporalmente desconectado". Simula perfectamente los Cortes Duros (Hard Cut) de cine, reteniendo identidad mientras reinicia el movimiento.

Análisis Profundo de Arquitectura M2V

Construcción del Banco de Memoria

Basado en ajuste fino Wan2.2-I2V + LoRA. Utiliza mecanismo de filtrado inteligente, manteniendo solo fotogramas clave de las últimas 10 tomas activas, simulando la "memoria de trabajo" humana para evitar el agotamiento de VRAM.

Selección Semántica de Fotogramas Clave

Introduce el modelo CLIP para calcular similitud coseno. Almacena solo cuadros que reflejan mejor las descripciones actuales del guion (ej: "expresión enojada"), descartando cuadros intermedios borrosos o parpadeando.

Filtrado de Preferencia Estética

Integra el modelo de puntuación HPSv3 como "Director de Arte IA". Filtra cuadros colapsados en tiempo real, asegurando que solo material de alta calidad estética permanezca en la memoria.

Concatenación de Espacio Latente

Los cuadros de memoria se comprimen en Latents vía VAE 3D, se concatenan con los vectores de ruido actuales en la dimensión del canal, y se inyectan vía adaptador LoRA Rank=128.

Evaluación Autorizada ST-Bench

Evaluación cuantitativa basada en 300 prompts narrativos multi-toma

Basado en cálculo de similitud coseno ViCLIP, cuantificando con precisión la capacidad de retención de identidad del protagonista.

Puntuación del predictor estético LAION, demostrando que el módulo de memoria no degradó los estándares artísticos.

El mecanismo de memoria no interfirió con la comprensión del modelo de nuevas instrucciones, respondiendo con precisión a cambios de guion.

Narración Guion-a-Video (Script-to-Video)

Entrada de guion estructurado JSON, controla tomas como un director

Sueño en el Pabellón Rojo: Daiyu Entra

AtmosphericComparación y Posicionamiento

Comparado con modelos como Open-Sora enfocados en simulación física, StoryMem se enfoca en Lógica Narrativa Cinematográfica.

❌ Proceso Aleatorio: Apariencia del personaje muta con cambios de toma, modelo no puede mantener imagen consistente.

✅ Inyección de Memoria: Incluso bajo diferentes ángulos e iluminación, detalles estructurales (ojos, color) permanecen altamente consistentes.

vs. Sora / Open-Sora

Sora tiende a generar un solo video largo continuo. StoryMem persigue Secuencias Narrativas compuestas por tomas de 5-10s, ajustándose a flujos de edición de cine profesional.

vs. AnimateDiff

AnimateDiff sobresale en bucles estilizados pero crea transiciones de morphing durante "Cortes Duros". StoryMem resuelve esto perfectamente vía RoPE negativo.

vs. IP-Adapter

IP-Adapter depende de una sola imagen de referencia, propenso a colapsar en dinámicas complejas. El banco de memoria dinámico de StoryMem captura características multi-ángulo.

StoryMem prueba que la "Memoria" es clave para realizar narración inteligente avanzada. Aunque actualmente limitado por la calidad del modelo base (ej: detalles de manos) y costos de VRAM (24GB recomendado), abre la puerta a "Estudios de Cine Unipersonales".

Perspectivas Futuras: Introducir Bancos de Memoria de Audio para consistencia de voz; explorar posibilidades de generación infinita para Películas Interactivas y Juegos con renderizado en tiempo real.

📄 Leer Paper Completo (ArXiv)