StoryMem

記憶を持つマルチショット長編動画ストーリーテリング

「ランダム生成」から「監督的思考」へ。明示的な視覚記憶バンクと負のRoPEシフト技術を通じて、StoryMemはマルチショットストーリーテリングにおける「忘却」の問題を解決し、映画レベルのショット間一貫性を実現しました。

コアブレイクスルーと進化

動画生成技術の「第三の道」

コアの課題:マルチショットの「忘却」

既存のDiTモデルは、各生成を独立したランダムプロセスとして扱います。「ロングショット」から「クローズアップ」に切り替わる際、意味的には合っていても、ピクセルレベルの特徴(髪型、服装の質感)が突然変異し、没入感を損なうことがよくあります。

明示的記憶バンク (Explicit Memory)

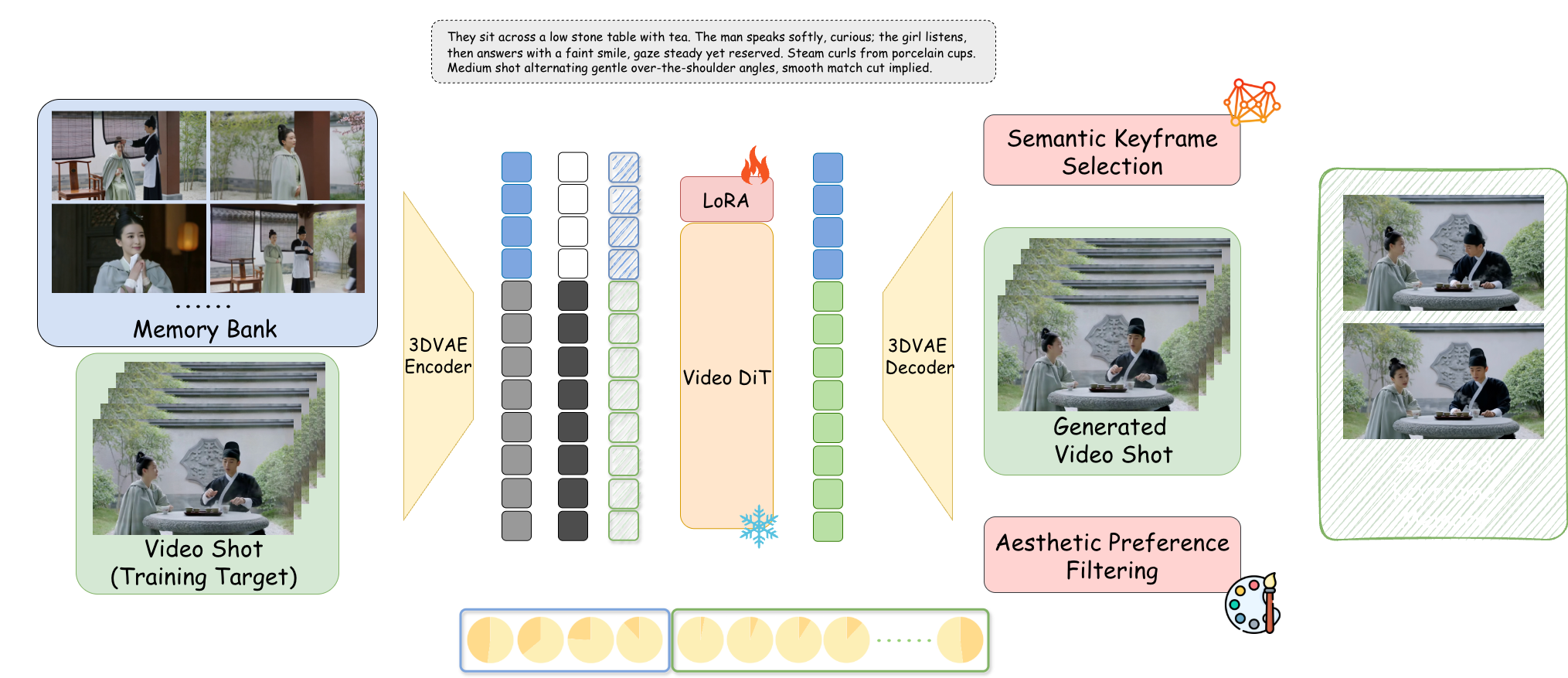

高計算コストの結合モデリングや単純な自己回帰を超えて。StoryMemは生成プロセスから独立した動的記憶モジュールを確立し、人間のワーキングメモリのように物語の文脈を維持します。

負のRoPEシフト

技術的特異点:記憶フレームに負の時間インデックスを付与することで、「意味的にはつながっているが時空間的には切断されている」注意メカニズムを作成しました。映画のハードカットを完璧にシミュレートし、アイデンティティを保持しながら動きをリセットします。

M2V アーキテクチャ詳細

記憶バンク構築

Wan2.2-I2V + LoRAファインチューニングに基づいています。インテリジェントなフィルタリングメカニズムを採用し、最近のアクティブな10ショットのキーフレームのみを保持して、人間の「ワーキングメモリ」を模倣し、VRAMの枯渇を防ぎます。

意味的キーフレーム選択

CLIPモデルを導入してコサイン類似度を計算します。現在の脚本の記述(例:「怒った表情」)を最も正確に反映するフレームのみを保存し、ぼやけたフレームや瞬きしている中間フレームを排除します。

美的嗜好フィルタリング

HPSv3スコアリングモデルを「AIアートディレクター」として統合。崩れた画面をリアルタイムで排除し、記憶バンクに高い美的品質の素材のみが残るようにします。

潜在空間連結

記憶フレームは3D VAEを介してLatentsに圧縮され、チャンネル次元で現在の生成ノイズベクトルと連結され、Rank=128のLoRAアダプターを介してモデルに注入されます。

ST-Bench 権威ある評価

300のマルチショット物語プロンプトに基づく定量的評価

ViCLIPコサイン類似度計算に基づき、主人公のアイデンティティ保持能力を正確に定量化。

LAION美的予測スコアにより、記憶モジュールが芸術的水準を低下させていないことを証明。

記憶メカニズムはモデルの新しい指示の理解を妨げず、脚本の変化に正確に応答します。

脚本駆動ストーリーテリング (Script-to-Video)

JSON構造化脚本入力、監督のようにショットを制御

紅楼夢:黛玉の入府

Atmospheric効果比較と位置付け

物理シミュレーションに焦点を当てたOpen-Soraなどのモデルと比較して、StoryMemは映画的物語ロジックに焦点を当てています。

❌ ランダムプロセス:ショットの切り替えに伴いキャラクターの外見が突然変異し、モデルは同一のイメージを維持できない。

✅ 記憶注入:異なる角度や照明の下でも、構造的詳細(目、色)は高度に一貫性を保つ。

vs. Sora / Open-Sora

Soraは単一の連続した長編動画を生成する傾向があります。StoryMemは5〜10秒のショットで構成される物語シーケンスを追求しており、プロの映像編集パイプラインにより適しています。

vs. AnimateDiff

AnimateDiffは様式化されたループには優れていますが、「ハードカット」を処理する際に変形遷移が発生します。StoryMemは負のRoPEによってこの問題を完全に解決します。

vs. IP-Adapter

IP-Adapterは単一の参照画像に依存しており、複雑な動きの中で崩れやすいです。StoryMemの動的記憶バンクは多角的な特徴を捉え、硬直を防ぎます。

StoryMemは、「記憶」が高レベルな知的ストーリーテリングを実現する鍵であることを証明しました。現在はベースモデルの画質(手の詳細など)やVRAMコスト(24GB推奨)に制限されていますが、「一人映画スタジオ」への扉を開きました。

今後の展望:声紋の一貫性を実現する音声記憶バンクの導入、リアルタイムレンダリングを組み合わせたインタラクティブ映画やゲームの無限生成の可能性の探求。

📄 論文全文を読む (ArXiv)