摘要

虽然现代人工智能在从视频生成音频方面取得了巨大进展,

但创建真正符合视觉内容细微差别的高保真声音仍然是一个主要障碍。

专业的音效设计需要对视觉线索、声学和时机进行复杂的推理——这项技能在人工智能中很难复制。

本文介绍了ThinkSound,这是一个开创性的框架,

教人工智能像音效设计师一样“思考”。通过使用思维链(CoT)推理,

ThinkSound将复杂的音频生成任务分解为合乎逻辑、易于管理的步骤。

这不仅可以从头开始创建声音,还可以使用简单的自然语言命令进行交互式、

以对象为中心的编辑和优化。为了支持这一点,我们还提出了AudioCoT,

这是首个为此类推理过程训练模型而设计的数据集。

我们的实验表明,ThinkSound在音频质量和相关性方面都树立了新的技术水平,

即使在复杂的、分布之外的电影场景中也表现出色。

与视频生成模型的协同作用

ThinkSound无缝地为领先的生成模型创建的视频添加丰富、同步的音景。以下视频由其各自的模型生成;所有音频均由ThinkSound创建。

Veo + ThinkSound

Sora + ThinkSound

MovieGen + ThinkSound

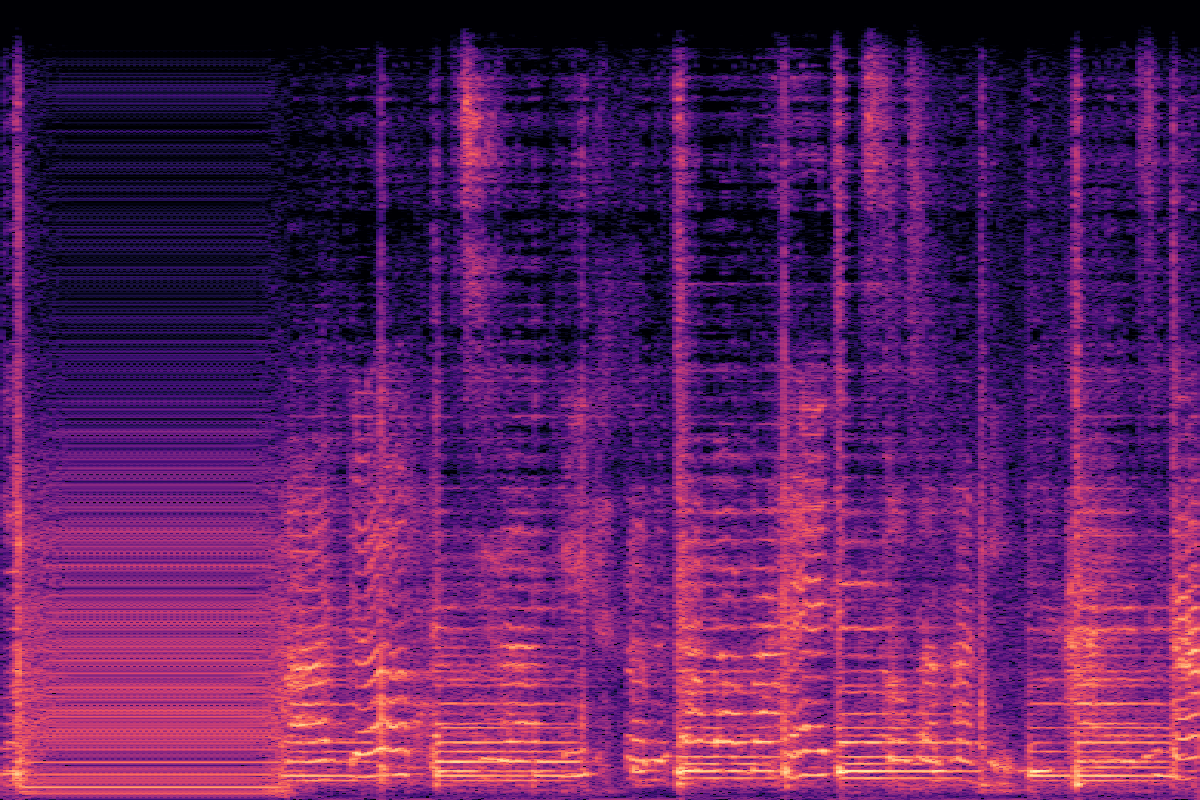

在VGGSound上的V2A比较(分布内)

点击任何缩略图以加载和播放视频,将ThinkSound与其他模型进行比较。

| CoT | 真实情况 | ThinkSound | MMAudio | See&Hear |

|---|---|---|---|---|

| 打网球 生成网球拍击球和球弹跳的声音... |  |  |  |  |

| 打印机打印 生成带有周期性蜂鸣声的连续打印机打印声... |  |  |  |  |

| 撕纸 从纸张被撕开的细微撕裂声开始... |  |  |  |  |

| 使用缝纫机 生成带有持续缝纫机嗡嗡声的环境缝纫室声音... |  |  |  |  |

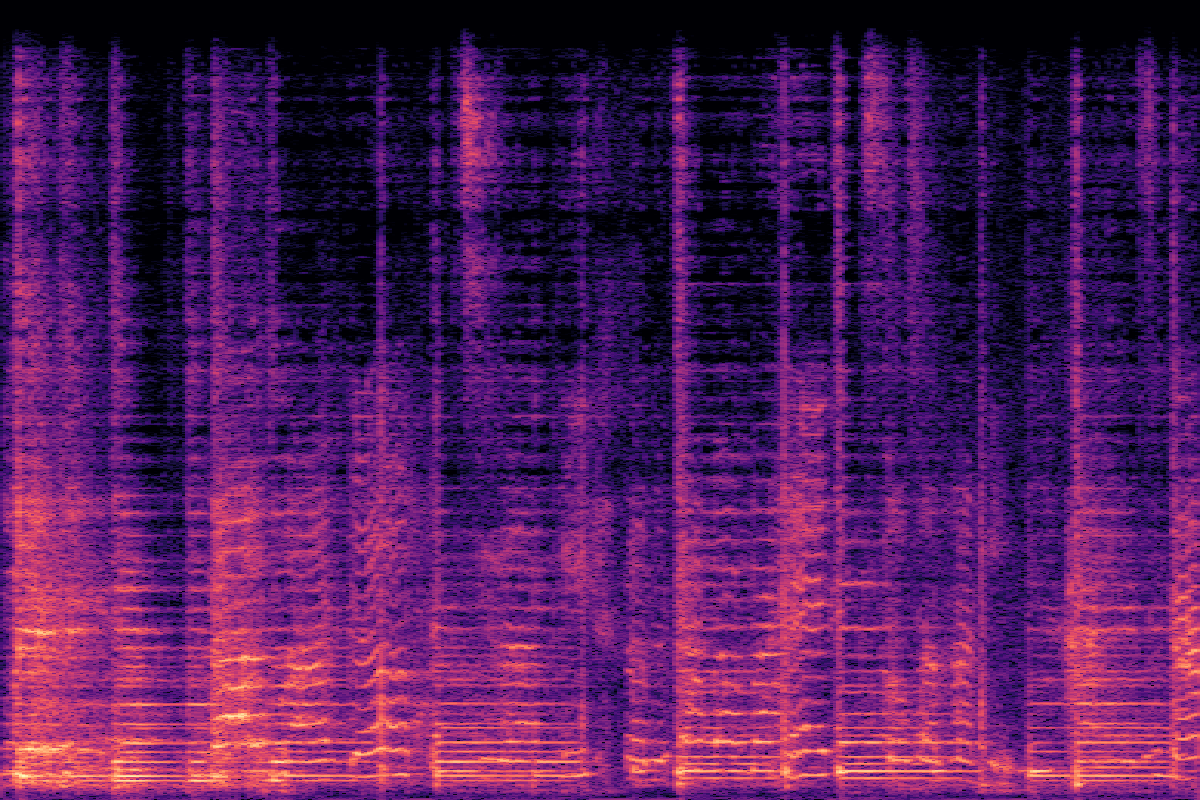

在MovieGen Audio上的V2A比较(分布外)

了解ThinkSound在具有挑战性的、分布之外的电影剪辑上的表现。

| CoT | ThinkSound | Movie Gen Audio | MMAudio |

|---|---|---|---|

| 轻柔的吸吮声 轻柔、稳定的奶嘴吸吮背景声... |  |  |  |

| 和谐的弦乐 原声吉他弦的嗡嗡声和蜂鸣声... |  |  |  |

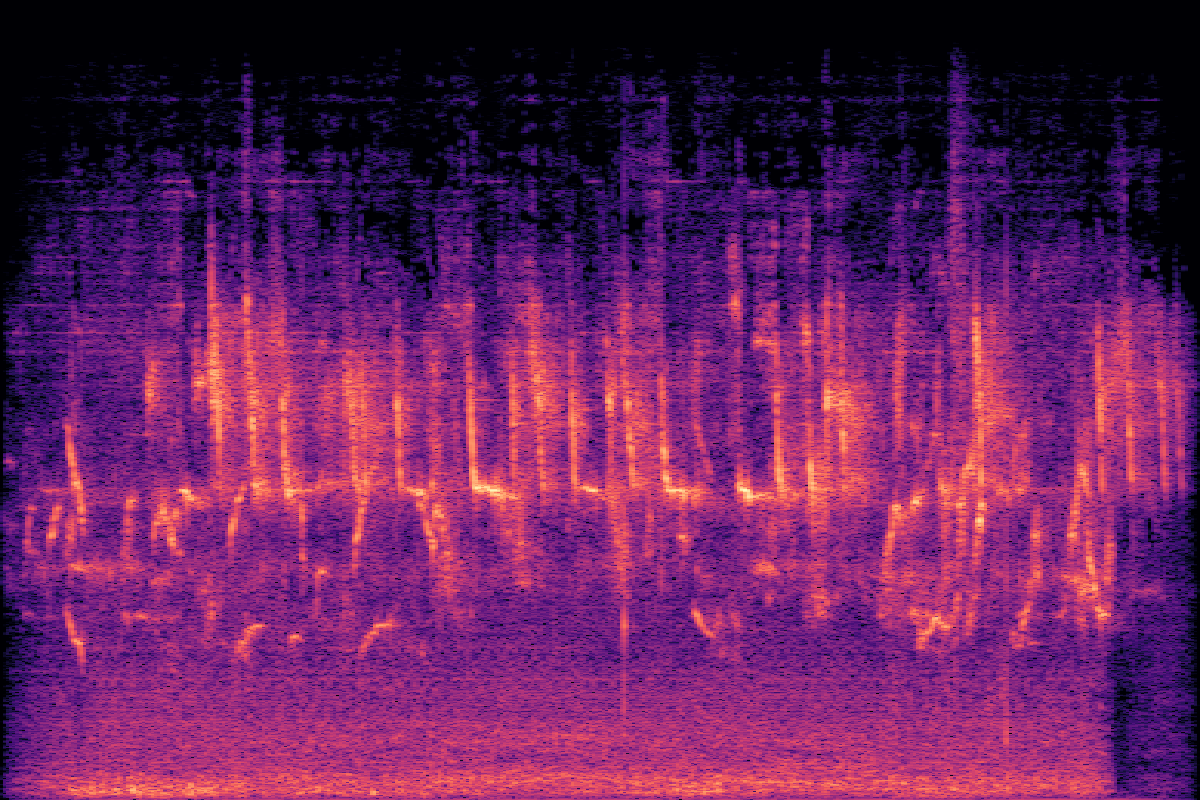

| 旧电视的嗡嗡声 带有微弱静电和白噪声的环境背景噪音... |  |  |  |

| 强烈的雷声 低沉的风声和偶尔的噼啪声增添了暴风雨的气氛... |  |  |  |

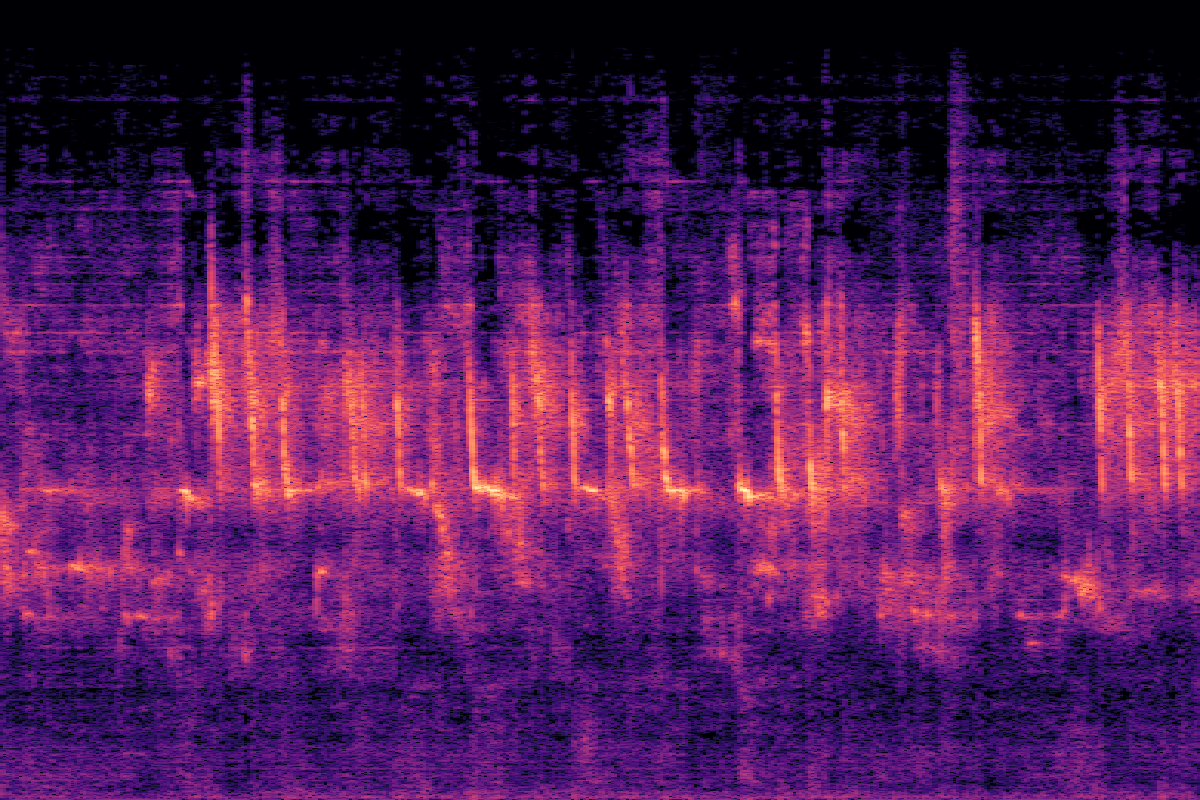

交互式分步拟音创作

V2A生成 → 对象聚焦 → 音频修复

V2A生成 → 对象聚焦 → 音频编辑

实验

在VGGSound上的主要结果

ThinkSound在大多数客观指标和所有主观指标上均优于所有基线,在音频质量和语义对齐方面取得了显著的改进。

| Method | Objective Metrics | Subjective Metrics | Efficiency | |||||||

|---|---|---|---|---|---|---|---|---|---|---|

| FD ↓ | KLPaSST ↓ | KLPaNNs ↓ | DeSync ↓ | CLAPcap ↑ | CLAPCoT ↑ | MOS-Q ↑ | MOS-A ↑ | Params | Time(s) ↓ | |

| GT | - | - | - | 0.55 | 0.28 | 0.45 | 4.37±0.21 | 4.56±0.19 | - | - |

| See&Hear | 118.95 | 2.26 | 2.30 | 1.20 | 0.32 | 0.35 | 2.75±1.08 | 2.87±0.99 | 415M | 19.42 |

| V-AURA† | 46.99 | 2.23 | 1.83 | 0.65 | 0.23 | 0.37 | 3.42±1.03 | 3.20±1.17 | 695M | 14.00 |

| FoleyCrafter | 39.15 | 2.06 | 1.89 | 1.21 | 0.41 | 0.34 | 3.08±1.21 | 2.63±0.88 | 1.20B | 3.84 |

| Frieren† | 74.96 | 2.55 | 2.64 | 1.00 | 0.37 | 0.34 | 3.27±1.11 | 2.95±1.09 | 159M | - |

| V2A-Mapper† | 48.10 | 2.50 | 2.34 | 1.23 | 0.38 | 0.32 | 3.31±1.02 | 3.16±1.04 | 229M | - |

| MMAudio | 43.26 | 1.65 | 1.40 | 0.44 | 0.31 | 0.40 | 3.84±0.89 | 3.97±0.82 | 1.03B | 3.01 |

| ThinkSound | 34.56 | 1.52 | 1.32 | 0.46 | 0.33 | 0.46 | 4.02±0.73 | 4.18±0.79 | 1.30B | 1.07 |

| w/o CoT Reasoning | 39.84 | 1.59 | 1.40 | 0.48 | 0.29 | 0.41 | 3.91±0.83 | 4.04±0.75 | 1.30B | 0.98 |

消融研究

我们研究了每个组件的贡献,以验证我们设计选择的有效性,重点关注文本编码和多模态集成。

文本编码策略

| Method | FD ↓ | KLPaSST ↓ | KLPaNNs ↓ | DeSync ↓ | CLAP ↑ |

|---|---|---|---|---|---|

| CLIP | 39.84 | 1.59 | 1.40 | 0.48 | 0.41 |

| T5 (CoT) | 37.65 | 1.54 | 1.35 | 0.46 | 0.44 |

| CLIP + T5 | 34.56 | 1.52 | 1.32 | 0.46 | 0.46 |

多模态集成

| Integration | FD ↓ | KLPaSST ↓ | KLPaNNs ↓ | DeSync ↓ | CLAP ↑ |

|---|---|---|---|---|---|

| audio only | 37.13 | 1.58 | 1.37 | 0.50 | 0.43 |

| linear video | 38.96 | 1.58 | 1.38 | 0.46 | 0.45 |

| gated video | 34.56 | 1.52 | 1.32 | 0.46 | 0.46 |

模型大小的影响

| Size | FD ↓ | KLPaSST ↓ | KLPaNNs ↓ | DeSync ↓ | CLAPCoT ↑ |

|---|---|---|---|---|---|

| Small | 40.80 | 1.64 | 1.38 | 0.46 | 0.41 |

| Medium | 36.80 | 1.56 | 1.34 | 0.46 | 0.44 |

| Large | 34.56 | 1.52 | 1.32 | 0.46 | 0.46 |

常见问题

ThinkSound是一个先进的人工智能框架,旨在为视频生成和编辑音频。与传统模型不同,它使用一种称为思维链(CoT)的推理过程来理解视频的上下文,并像专业音效设计师一样创建高度相关、高质量的声音。

思维链允许模型将复杂的任务(如“为此视频创建配乐”)分解为更小、更合乎逻辑的步骤。例如,它可能首先识别主要对象和动作,然后对环境的声学进行推理,最后决定适当的声音及其时机。这种循序渐进的过程可以实现更准确、更具上下文感知能力的音频生成。

主要有三点:1)它使用CoT推理进行更智能的声音创作。2)它的交互性,允许用户使用自然语言编辑音频、专注于特定对象并优化声音。3)它由AudioCoT提供支持,这是一个专门为训练这种基于推理的音频生成而构建的独特数据集。

可以!我们在此页面顶部链接的Hugging Face Spaces上提供了交互式演示。您还可以在GitHub上探索源代码以自行运行模型。