초록

현대 AI가 비디오에서 오디오를 생성하는 데 큰 발전을 이루었지만,

시각적 콘텐츠의 미묘한 차이를 진정으로 반영하는 고음질 사운드를 만드는 것은

여전히 큰 장애물입니다. 전문적인 사운드 디자인은 시각적 단서, 음향 및 타이밍에 대한

복잡한 추론을 필요로 하며, 이는 AI에서 복제하기 어려운 기술이었습니다.

이 논문은 AI에게 사운드 디자이너처럼 "생각"하도록 가르치는 획기적인 프레임워크인

ThinkSound를 소개합니다. 연쇄 사고(CoT) 추론을 사용하여

ThinkSound는 오디오 생성의 복잡한 작업을 논리적이고 관리 가능한 단계로 나눕니다.

이를 통해 처음부터 사운드를 생성할 뿐만 아니라 간단한 자연어 명령을 사용하여

대화형의 객체 중심 편집 및 개선이 가능합니다. 이를 지원하기 위해,

이 추론 과정에 대한 모델을 훈련시키기 위해 설계된 최초의 데이터셋인

AudioCoT도 제시합니다. 우리의 실험은 ThinkSound가

오디오 품질과 관련성 모두에서 새로운 최첨단 기술을 설정하고, 복잡하고

분포를 벗어난 영화 장면에서도 매우 뛰어난 성능을 보인다는 것을 보여줍니다.

비디오 생성 모델과의 시너지

ThinkSound는 선도적인 생성 모델로 만든 비디오에 풍부하고 동기화된 사운드스케이프를 원활하게 추가합니다. 아래 비디오는 각 모델에 의해 생성되었으며 모든 오디오는 ThinkSound에 의해 생성되었습니다.

Veo + ThinkSound

Sora + ThinkSound

MovieGen + ThinkSound

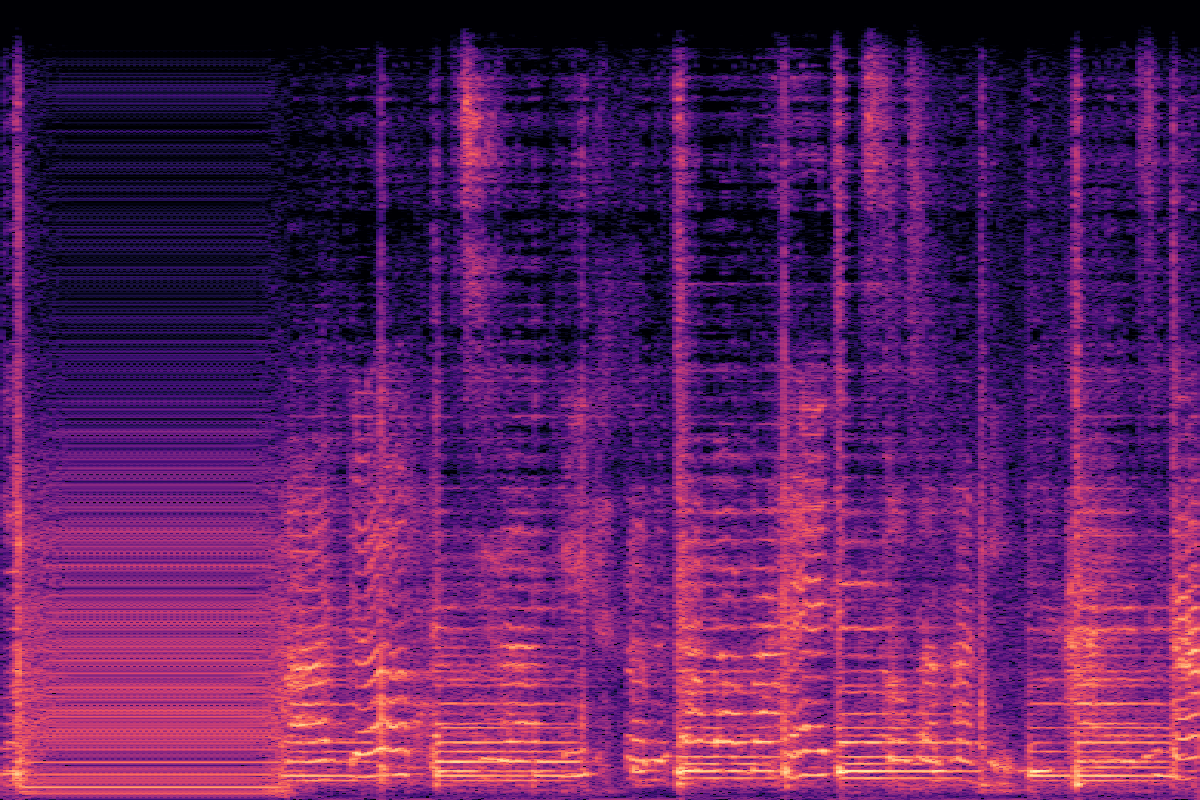

VGGSound에서의 V2A 비교 (분포 내)

썸네일을 클릭하여 비디오를 로드하고 재생하여 ThinkSound를 다른 모델과 비교하세요.

| CoT | 실제값 | ThinkSound | MMAudio | See&Hear |

|---|---|---|---|---|

| 테니스 치기 테니스 라켓에 공이 부딪히고 공이 튀는 소리 생성... |  |  |  |  |

| 프린터 인쇄 주기적인 신호음과 함께 연속적인 프린터 인쇄 소리 생성... |  |  |  |  |

| 종이 찢기 종이가 찢어지는 미세한 소리로 시작... |  |  |  |  |

| 재봉틀 사용 일관된 재봉틀 소음과 함께 주변 재봉실 소리 생성... |  |  |  |  |

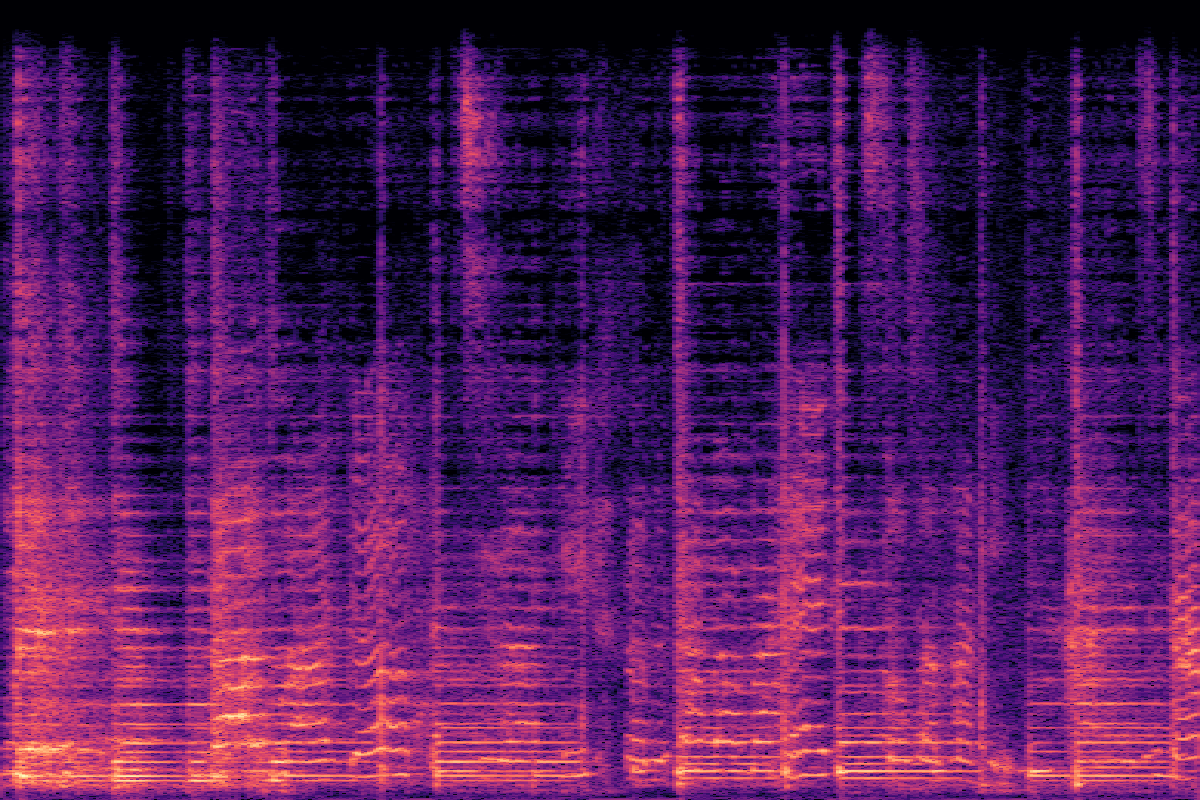

MovieGen Audio에서의 V2A 비교 (분포 외)

ThinkSound가 어렵고 분포를 벗어난 영화 클립에서 어떻게 작동하는지 확인하세요.

| CoT | ThinkSound | Movie Gen Audio | MMAudio |

|---|---|---|---|

| 부드러운 빠는 소리 가벼운 젖꼭지 빠는 소리의 부드럽고 꾸준한 배경음... |  |  |  |

| 조화로운 현악기 어쿠스틱 기타 현이 윙윙거리고 웅웅거리는 소리... |  |  |  |

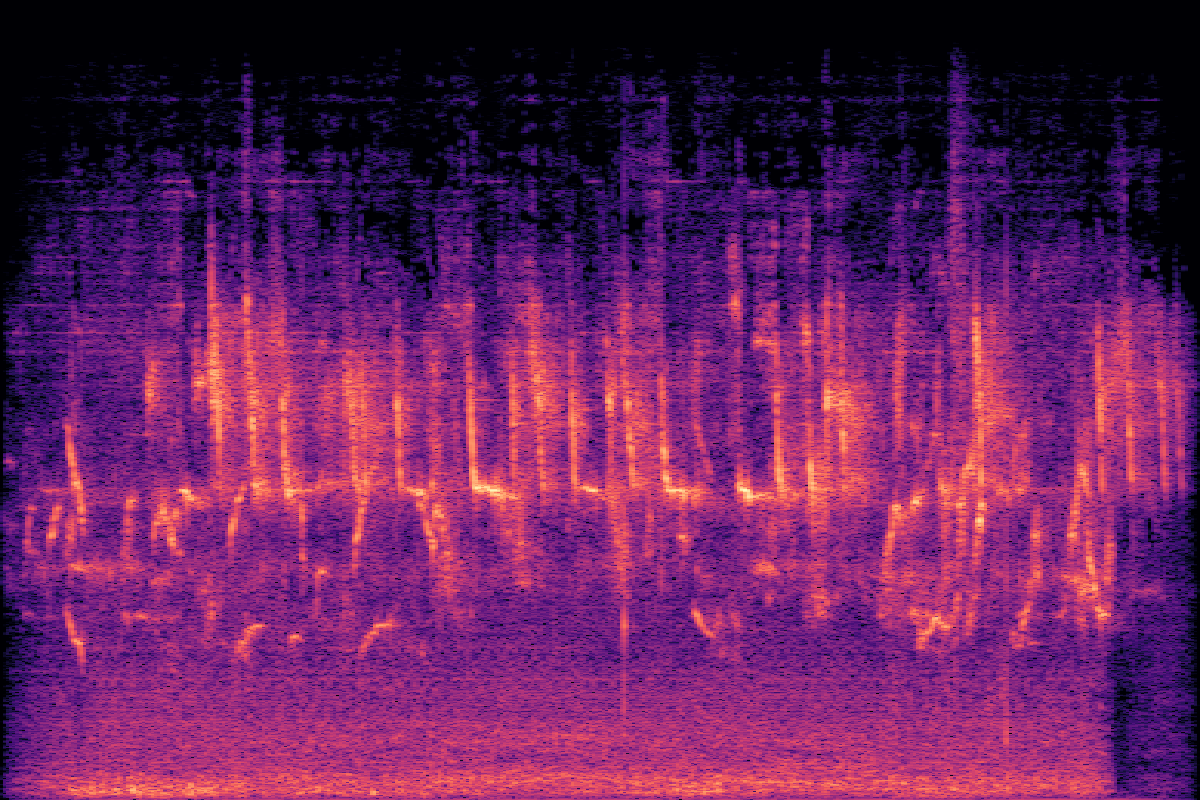

| 오래된 TV 윙윙거림 희미한 정전기와 백색 소음이 있는 주변 배경 소음... |  |  |  |

| 강렬한 천둥 낮은 바람 소리와 가끔씩의 딱딱거리는 소리가 폭풍우 치는 분위기를 더합니다... |  |  |  |

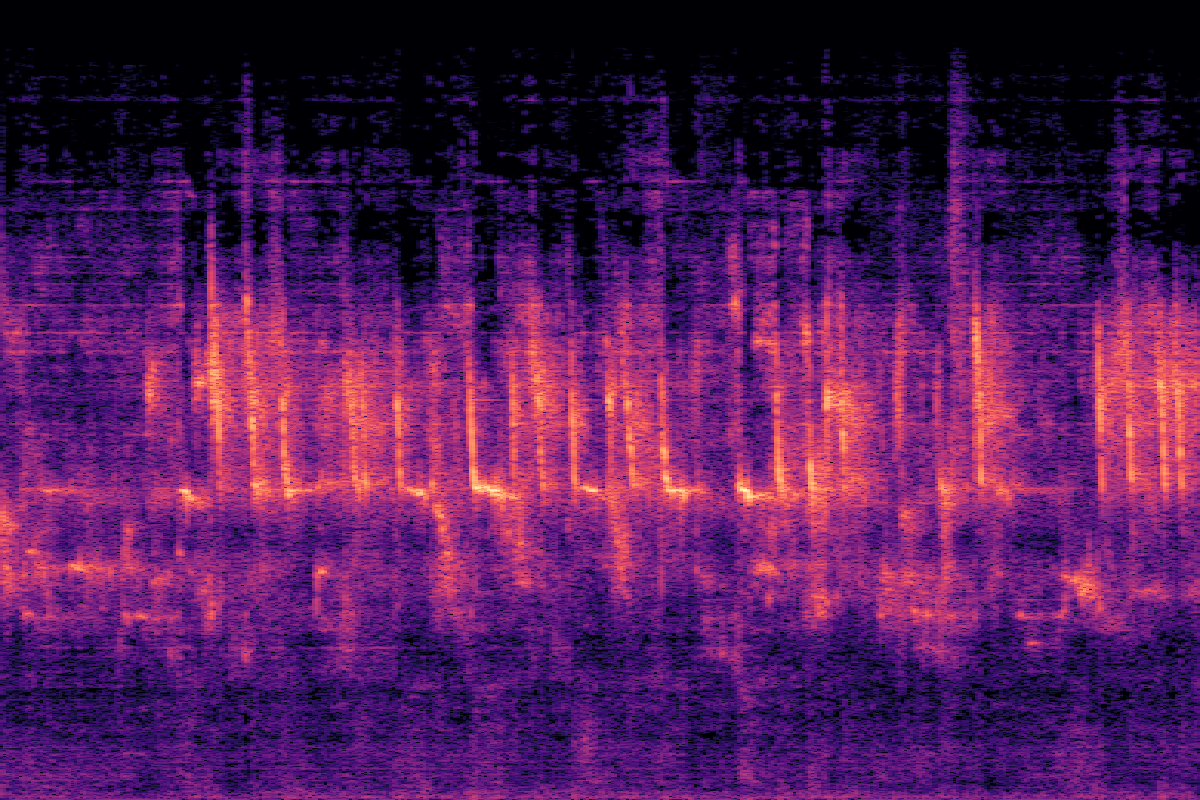

대화형 단계별 폴리 제작

V2A 생성 → 객체 초점 → 오디오 인페인팅

V2A 생성 → 객체 초점 → 오디오 편집

실험

VGGSound에 대한 주요 결과

ThinkSound는 대부분의 객관적 지표와 모든 주관적 지표에서 모든 기준선을 능가하며 오디오 품질과 의미론적 정렬에서 상당한 개선을 달성합니다.

| Method | Objective Metrics | Subjective Metrics | Efficiency | |||||||

|---|---|---|---|---|---|---|---|---|---|---|

| FD ↓ | KLPaSST ↓ | KLPaNNs ↓ | DeSync ↓ | CLAPcap ↑ | CLAPCoT ↑ | MOS-Q ↑ | MOS-A ↑ | Params | Time(s) ↓ | |

| GT | - | - | - | 0.55 | 0.28 | 0.45 | 4.37±0.21 | 4.56±0.19 | - | - |

| See&Hear | 118.95 | 2.26 | 2.30 | 1.20 | 0.32 | 0.35 | 2.75±1.08 | 2.87±0.99 | 415M | 19.42 |

| V-AURA† | 46.99 | 2.23 | 1.83 | 0.65 | 0.23 | 0.37 | 3.42±1.03 | 3.20±1.17 | 695M | 14.00 |

| FoleyCrafter | 39.15 | 2.06 | 1.89 | 1.21 | 0.41 | 0.34 | 3.08±1.21 | 2.63±0.88 | 1.20B | 3.84 |

| Frieren† | 74.96 | 2.55 | 2.64 | 1.00 | 0.37 | 0.34 | 3.27±1.11 | 2.95±1.09 | 159M | - |

| V2A-Mapper† | 48.10 | 2.50 | 2.34 | 1.23 | 0.38 | 0.32 | 3.31±1.02 | 3.16±1.04 | 229M | - |

| MMAudio | 43.26 | 1.65 | 1.40 | 0.44 | 0.31 | 0.40 | 3.84±0.89 | 3.97±0.82 | 1.03B | 3.01 |

| ThinkSound | 34.56 | 1.52 | 1.32 | 0.46 | 0.33 | 0.46 | 4.02±0.73 | 4.18±0.79 | 1.30B | 1.07 |

| w/o CoT Reasoning | 39.84 | 1.59 | 1.40 | 0.48 | 0.29 | 0.41 | 3.91±0.83 | 4.04±0.75 | 1.30B | 0.98 |

절제 연구

텍스트 인코딩 및 다중 모드 통합에 중점을 두고 설계 선택의 효율성을 검증하기 위해 각 구성 요소의 기여도를 조사했습니다.

텍스트 인코딩 전략

| Method | FD ↓ | KLPaSST ↓ | KLPaNNs ↓ | DeSync ↓ | CLAP ↑ |

|---|---|---|---|---|---|

| CLIP | 39.84 | 1.59 | 1.40 | 0.48 | 0.41 |

| T5 (CoT) | 37.65 | 1.54 | 1.35 | 0.46 | 0.44 |

| CLIP + T5 | 34.56 | 1.52 | 1.32 | 0.46 | 0.46 |

다중 모드 통합

| Integration | FD ↓ | KLPaSST ↓ | KLPaNNs ↓ | DeSync ↓ | CLAP ↑ |

|---|---|---|---|---|---|

| audio only | 37.13 | 1.58 | 1.37 | 0.50 | 0.43 |

| linear video | 38.96 | 1.58 | 1.38 | 0.46 | 0.45 |

| gated video | 34.56 | 1.52 | 1.32 | 0.46 | 0.46 |

모델 크기의 영향

| Size | FD ↓ | KLPaSST ↓ | KLPaNNs ↓ | DeSync ↓ | CLAPCoT ↑ |

|---|---|---|---|---|---|

| Small | 40.80 | 1.64 | 1.38 | 0.46 | 0.41 |

| Medium | 36.80 | 1.56 | 1.34 | 0.46 | 0.44 |

| Large | 34.56 | 1.52 | 1.32 | 0.46 | 0.46 |

자주 묻는 질문

ThinkSound는 비디오용 오디오를 생성하고 편집하도록 설계된 고급 AI 프레임워크입니다. 기존 모델과 달리 연쇄 사고(CoT)라는 추론 과정을 사용하여 비디오의 맥락을 이해하고 전문 사운드 디자이너처럼 관련성이 높은 고품질 사운드를 생성합니다.

연쇄 사고를 통해 모델은 복잡한 작업("이 비디오의 사운드트랙 만들기"와 같은)을 더 작고 논리적인 단계로 나눌 수 있습니다. 예를 들어, 먼저 주요 객체와 동작을 식별한 다음 환경의 음향에 대해 추론하고 마지막으로 적절한 사운드와 타이밍을 결정합니다. 이 단계별 프로세스는 더 정확하고 맥락을 인식하는 오디오 생성으로 이어집니다.

주요 세 가지: 1) 더 지능적인 사운드 생성을 위한 CoT 추론 사용. 2) 사용자가 오디오를 편집하고 특정 객체에 초점을 맞추고 자연어를 사용하여 사운드를 다듬을 수 있는 상호 작용성. 3) 이러한 종류의 추론 기반 오디오 생성을 훈련시키기 위해 특별히 제작된 고유한 데이터셋인 AudioCoT로 구동된다는 점.

네! 이 페이지 상단에 링크된 Hugging Face Spaces에서 대화형 데모를 제공했습니다. GitHub에서 소스 코드를 탐색하여 직접 모델을 실행할 수도 있습니다.