概要

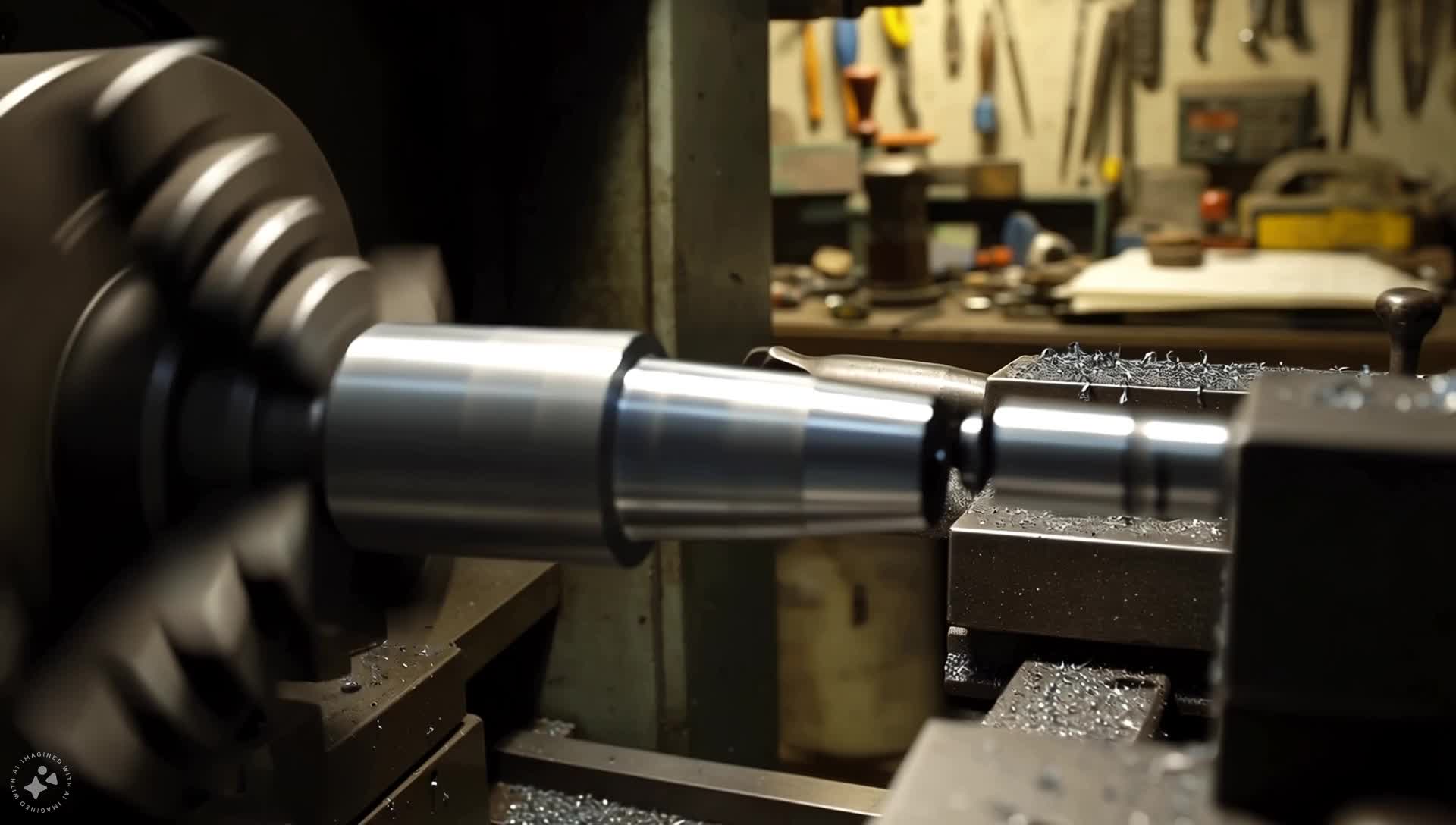

現代のAIはビデオからの音声生成で大きな進歩を遂げましたが、

視覚コンテンツのニュアンスに真に一致する高忠実度のサウンドを作成することは依然として大きな課題です。

プロのサウンドデザインには、視覚的な手がかり、音響、タイミングに関する複雑な推論が必要であり、

これはAIで再現するのが困難なスキルでした。

この論文では、AIにサウンドデザイナーのように「考える」ことを教える画期的なフレームワーク

ThinkSoundを紹介します。思考の連鎖(CoT)推論を使用することで、

ThinkSoundは音声生成の複雑なタスクを論理的で管理可能なステップに分解します。

これにより、ゼロからサウンドを作成するだけでなく、簡単な自然言語コマンドを使用して

対話的でオブジェクトに焦点を当てた編集と洗練が可能になります。

これを実現するために、この推論プロセスでモデルをトレーニングするために設計された

初のデータセットであるAudioCoTも提示します。

私たちの実験は、ThinkSoundが音質と関連性の両方で新たな最先端技術を確立し、

複雑で分布外の映画シーンでも非常に優れたパフォーマンスを発揮することを示しています。

ビデオ生成モデルとの相乗効果

ThinkSoundは、主要な生成モデルによって作成されたビデオに、豊かで同期したサウンドスケープをシームレスに追加します。以下のビデオはそれぞれのモデルによって生成されたもので、すべての音声はThinkSoundによって作成されました。

Veo + ThinkSound

Sora + ThinkSound

MovieGen + ThinkSound

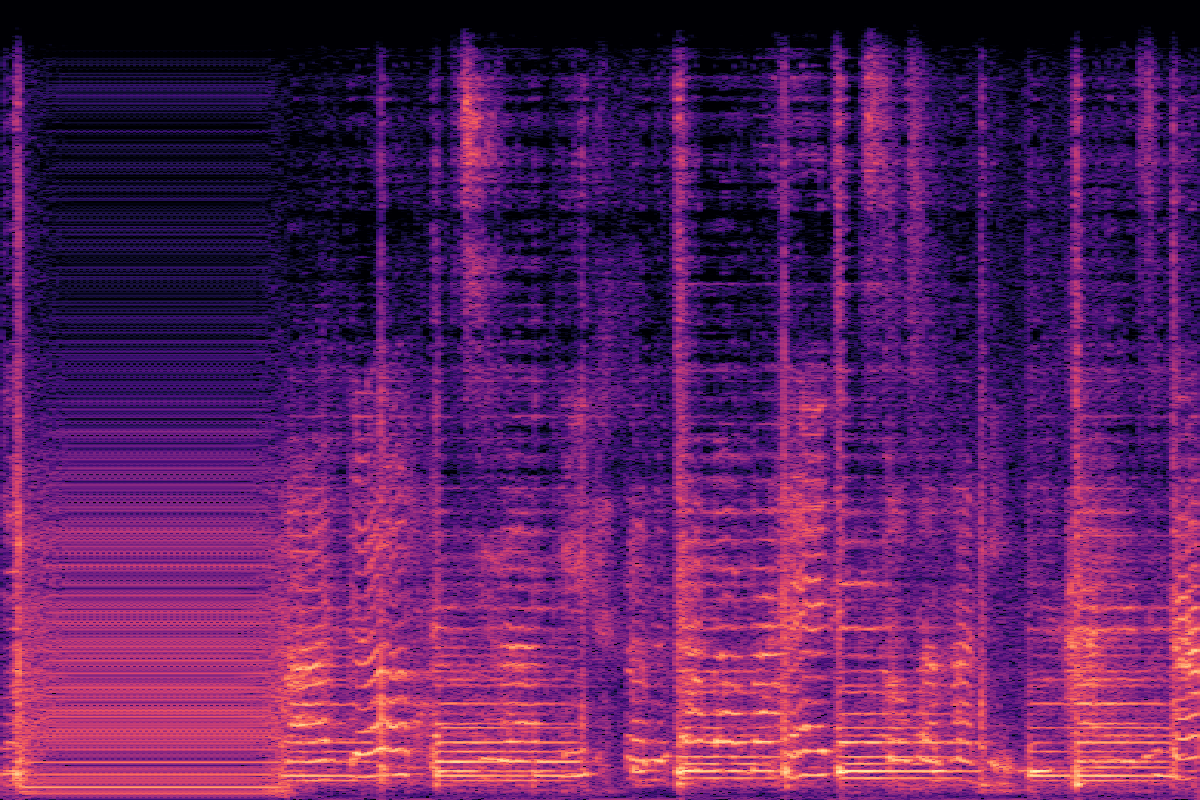

VGGSoundでのV2A比較(分布内)

サムネイルをクリックしてビデオを読み込み、再生し、ThinkSoundを他のモデルと比較します。

| CoT | グラウンドトゥルース | ThinkSound | MMAudio | See&Hear |

|---|---|---|---|---|

| テニスをする テニスラケットにボールが当たる音とボールが跳ねる音を生成... |  |  |  |  |

| プリンターの印刷 定期的なビープ音とともに連続的なプリンターの印刷音を生成... |  |  |  |  |

| 紙を破る 紙が破られる微妙な引き裂き音から始める... |  |  |  |  |

| ミシンの使用 一貫したミシンのハミング音で環境の裁縫室の音を生成... |  |  |  |  |

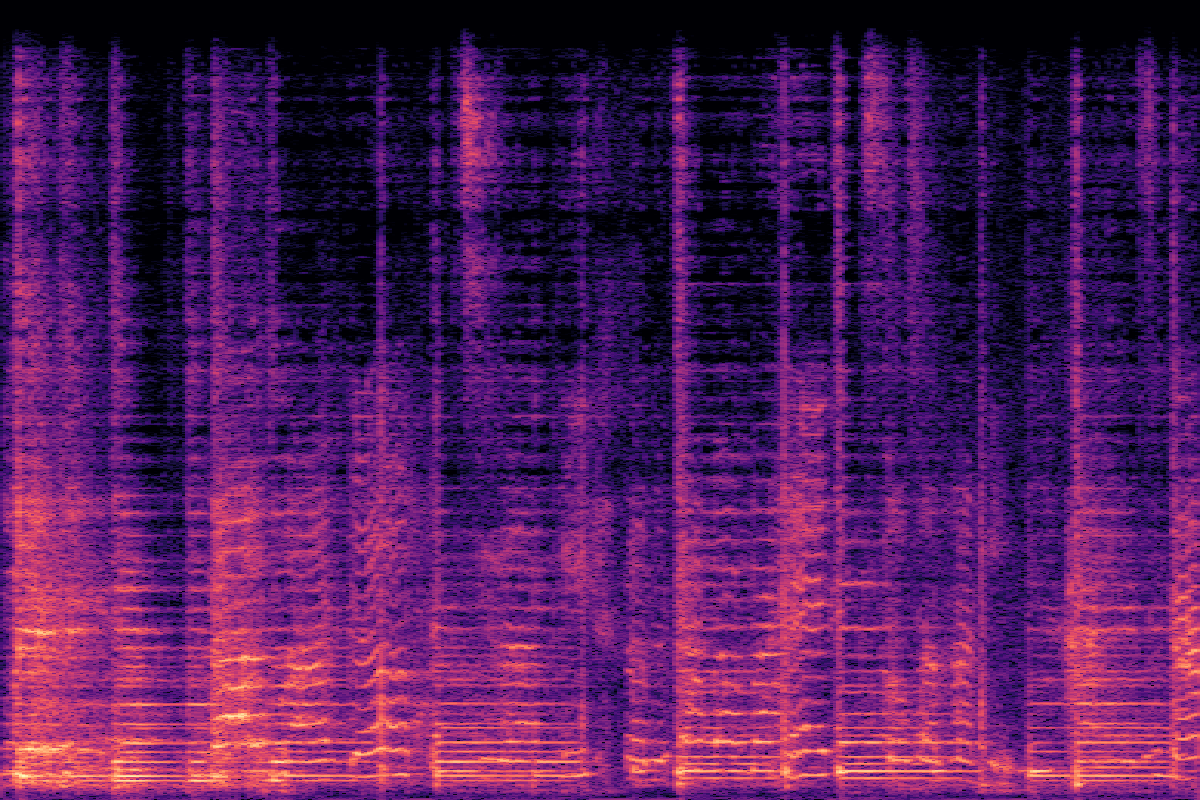

MovieGen AudioでのV2A比較(分布外)

ThinkSoundが挑戦的で分布外の映画クリップでどのように機能するかをご覧ください。

| CoT | ThinkSound | Movie Gen Audio | MMAudio |

|---|---|---|---|

| 穏やかな吸う音 軽くおしゃぶりを吸う柔らかく安定した背景音... |  |  |  |

| 調和のとれた弦楽器 アコースティックギターの弦がハミングし、ブンブン鳴る... |  |  |  |

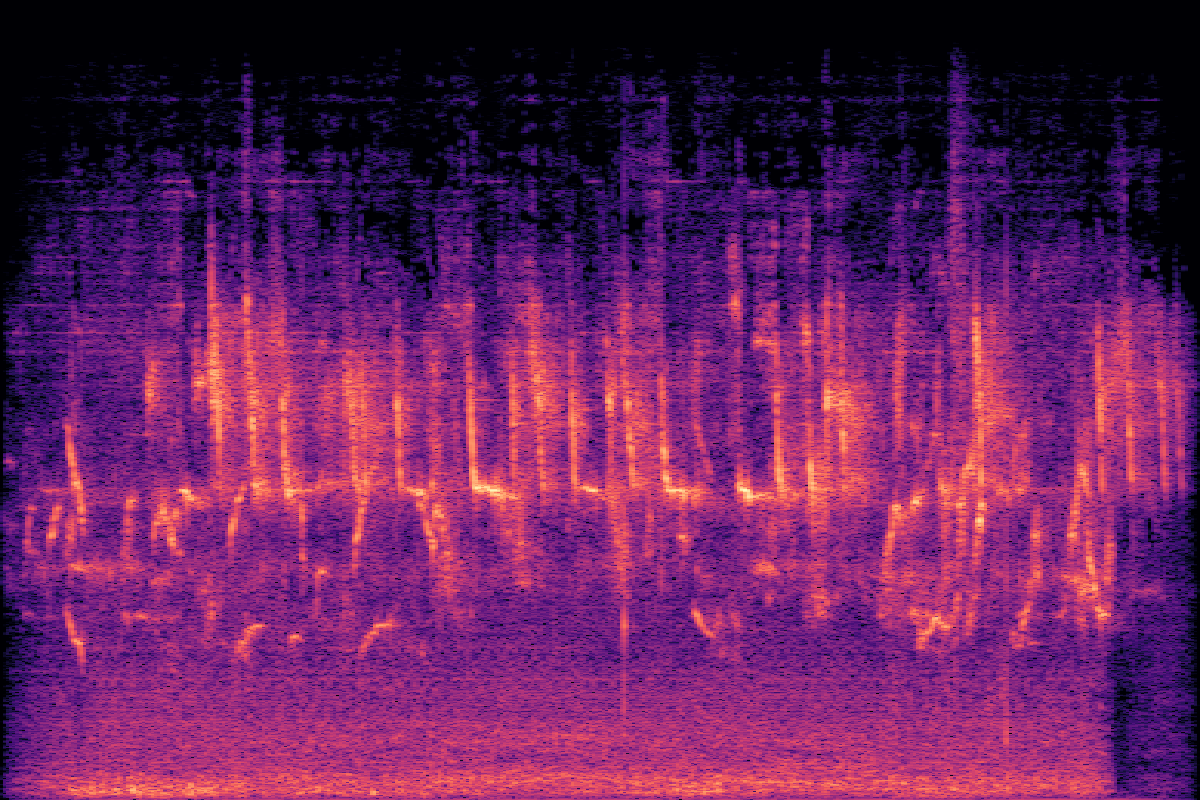

| 古いテレビのハミング かすかな静電気とホワイトノイズのある環境背景ノイズ... |  |  |  |

| 激しい雷 低い風のハミングと時折のパチパチという音が嵐の雰囲気を増す... |  |  |  |

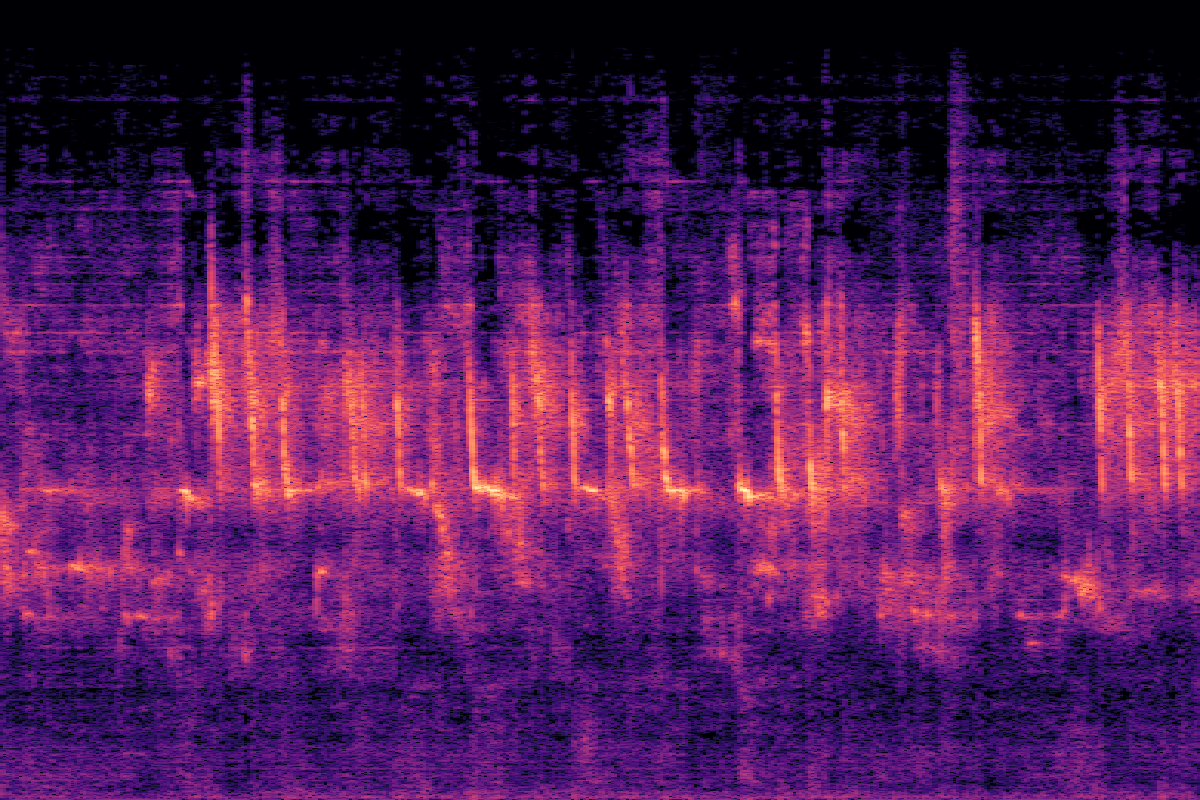

対話的なステップバイステップのフォーリー作成

V2A生成 → オブジェクトフォーカス → 音声インペインティング

V2A生成 → オブジェクトフォーカス → 音声編集

実験

VGGSoundでの主な結果

ThinkSoundは、ほとんどの客観的指標とすべての主観的指標で、すべてのベースラインを上回り、音質と意味的整合性で大幅な改善を達成しています。

| Method | Objective Metrics | Subjective Metrics | Efficiency | |||||||

|---|---|---|---|---|---|---|---|---|---|---|

| FD ↓ | KLPaSST ↓ | KLPaNNs ↓ | DeSync ↓ | CLAPcap ↑ | CLAPCoT ↑ | MOS-Q ↑ | MOS-A ↑ | Params | Time(s) ↓ | |

| GT | - | - | - | 0.55 | 0.28 | 0.45 | 4.37±0.21 | 4.56±0.19 | - | - |

| See&Hear | 118.95 | 2.26 | 2.30 | 1.20 | 0.32 | 0.35 | 2.75±1.08 | 2.87±0.99 | 415M | 19.42 |

| V-AURA† | 46.99 | 2.23 | 1.83 | 0.65 | 0.23 | 0.37 | 3.42±1.03 | 3.20±1.17 | 695M | 14.00 |

| FoleyCrafter | 39.15 | 2.06 | 1.89 | 1.21 | 0.41 | 0.34 | 3.08±1.21 | 2.63±0.88 | 1.20B | 3.84 |

| Frieren† | 74.96 | 2.55 | 2.64 | 1.00 | 0.37 | 0.34 | 3.27±1.11 | 2.95±1.09 | 159M | - |

| V2A-Mapper† | 48.10 | 2.50 | 2.34 | 1.23 | 0.38 | 0.32 | 3.31±1.02 | 3.16±1.04 | 229M | - |

| MMAudio | 43.26 | 1.65 | 1.40 | 0.44 | 0.31 | 0.40 | 3.84±0.89 | 3.97±0.82 | 1.03B | 3.01 |

| ThinkSound | 34.56 | 1.52 | 1.32 | 0.46 | 0.33 | 0.46 | 4.02±0.73 | 4.18±0.79 | 1.30B | 1.07 |

| w/o CoT Reasoning | 39.84 | 1.59 | 1.40 | 0.48 | 0.29 | 0.41 | 3.91±0.83 | 4.04±0.75 | 1.30B | 0.98 |

アブレーション研究

テキストエンコーディングとマルチモーダル統合に焦点を当て、設計選択の有効性を検証するために各コンポーネントの貢献を調査しました。

テキストエンコーディング戦略

| Method | FD ↓ | KLPaSST ↓ | KLPaNNs ↓ | DeSync ↓ | CLAP ↑ |

|---|---|---|---|---|---|

| CLIP | 39.84 | 1.59 | 1.40 | 0.48 | 0.41 |

| T5 (CoT) | 37.65 | 1.54 | 1.35 | 0.46 | 0.44 |

| CLIP + T5 | 34.56 | 1.52 | 1.32 | 0.46 | 0.46 |

マルチモーダル統合

| Integration | FD ↓ | KLPaSST ↓ | KLPaNNs ↓ | DeSync ↓ | CLAP ↑ |

|---|---|---|---|---|---|

| audio only | 37.13 | 1.58 | 1.37 | 0.50 | 0.43 |

| linear video | 38.96 | 1.58 | 1.38 | 0.46 | 0.45 |

| gated video | 34.56 | 1.52 | 1.32 | 0.46 | 0.46 |

モデルサイズの影響

| Size | FD ↓ | KLPaSST ↓ | KLPaNNs ↓ | DeSync ↓ | CLAPCoT ↑ |

|---|---|---|---|---|---|

| Small | 40.80 | 1.64 | 1.38 | 0.46 | 0.41 |

| Medium | 36.80 | 1.56 | 1.34 | 0.46 | 0.44 |

| Large | 34.56 | 1.52 | 1.32 | 0.46 | 0.46 |

よくある質問

ThinkSoundは、ビデオ用の音声を生成および編集するために設計された高度なAIフレームワークです。従来のモデルとは異なり、思考の連鎖(CoT)と呼ばれる推論プロセスを使用してビデオのコンテキストを理解し、プロのサウンドデザイナーのように、関連性が高く高品質のサウンドを作成します。

思考の連鎖により、モデルは複雑なタスク(「このビデオのサウンドトラックを作成する」など)をより小さく論理的なステップに分解できます。たとえば、最初に主要なオブジェクトとアクションを特定し、次に環境の音響について推論し、最後に適切なサウンドとそのタイミングを決定します。このステップバイステップのプロセスにより、より正確で文脈を意識した音声生成が可能になります。

主な3つの点:1)よりインテリジェントなサウンド作成のためのCoT推論の使用。2)ユーザーが音声を編集し、特定のオブジェクトに焦点を合わせ、自然言語を使用してサウンドを洗練できる対話性。3)この種の推論ベースの音声生成をトレーニングするために特別に構築された独自のデータセットであるAudioCoTを搭載していること。

はい!このページの上部にあるHugging Face Spacesでインタラクティブなデモを提供しています。また、GitHubでソースコードを調べて、自分でモデルを実行することもできます。