ThinkSound

Wegweisende Audiogenerierung und -bearbeitung mit Chain-of-Thought-Reasoning

Zusammenfassung

Obwohl die moderne KI große Fortschritte bei der Erzeugung von Audio aus Videos gemacht hat,

bleibt die Erstellung von High-Fidelity-Sound, der wirklich der Nuance des visuellen

Inhalts entspricht, eine große Hürde. Professionelles Sounddesign erfordert

komplexes Denken über visuelle Hinweise, Akustik und Timing – eine Fähigkeit, die

in der KI schwer zu replizieren war.

Dieses Papier stellt ThinkSound vor, ein bahnbrechendes

Framework, das KI beibringt, wie ein Sounddesigner zu "denken". Durch die Verwendung

von Chain-of-Thought (CoT)-Reasoning zerlegt ThinkSound die komplexe

Aufgabe der Audiogenerierung in logische, überschaubare Schritte. Dies ermöglicht

nicht nur die Erstellung von Sound von Grund auf, sondern auch die interaktive,

objektfokussierte Bearbeitung und Verfeinerung mit einfachen Befehlen in natürlicher Sprache.

Um dies zu ermöglichen, präsentieren wir auch AudioCoT, einen

einzigartigen Datensatz, der entwickelt wurde, um Modelle in diesem Denkprozess zu trainieren.

Unsere Experimente zeigen, dass ThinkSound einen neuen

Stand der Technik in Bezug auf Audioqualität und Relevanz setzt und

selbst bei komplexen, nicht zur Verteilung gehörenden Filmszenen außergewöhnlich gut abschneidet.

Synergie mit Videogenerierungsmodellen

ThinkSound fügt nahtlos reichhaltige, synchronisierte Klanglandschaften zu Videos hinzu, die von führenden generativen Modellen erstellt wurden. Die folgenden Videos wurden von ihren jeweiligen Modellen generiert; der gesamte Ton wurde von ThinkSound erstellt.

Veo + ThinkSound

Sora + ThinkSound

MovieGen + ThinkSound

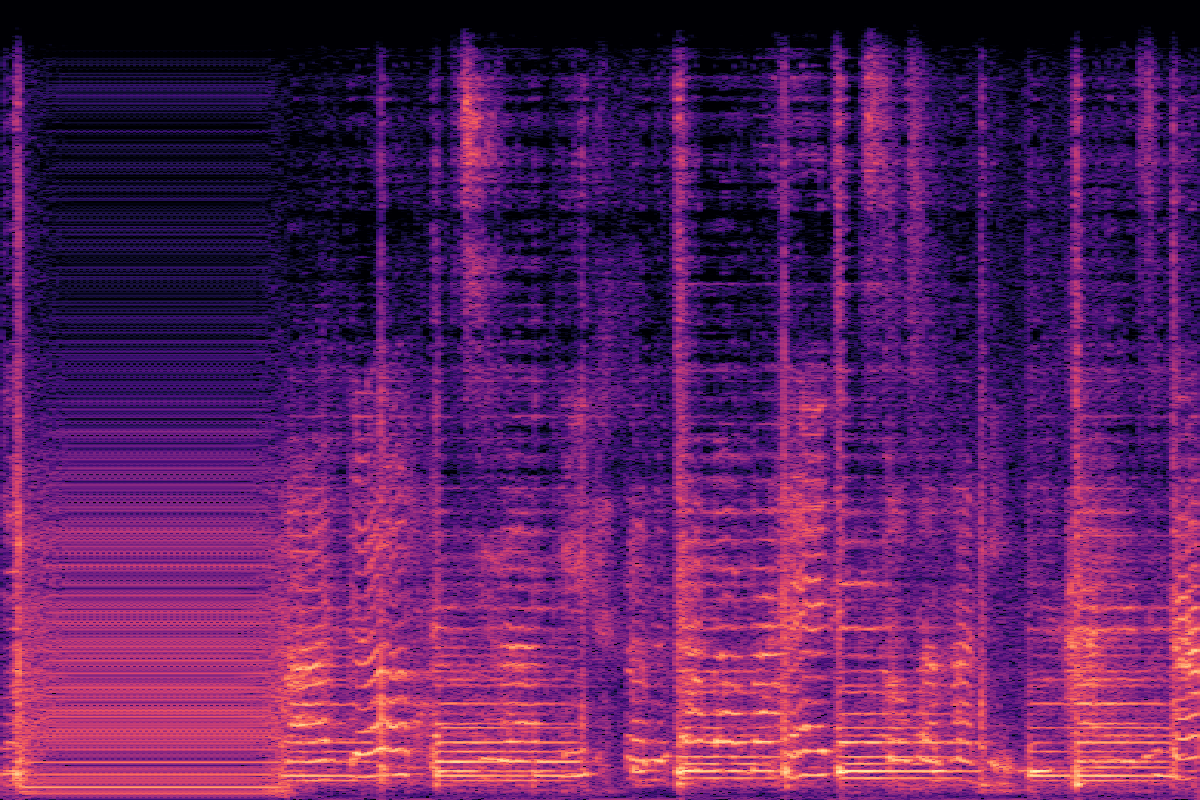

V2A-Vergleiche auf VGGSound (In-Distribution)

Klicken Sie auf eine Miniaturansicht, um das Video zu laden und abzuspielen und ThinkSound mit anderen Modellen zu vergleichen.

| CoT | Ground Truth | ThinkSound | MMAudio | See&Hear |

|---|---|---|---|---|

| Tennis spielen Erzeugen Sie Geräusche von einem Tennisschläger, der einen Ball trifft, und dem Aufprall des Balls... |  |  |  |  |

| Drucker druckt Erzeugen Sie ein kontinuierliches Druckergeräusch mit periodischen Pieptönen... |  |  |  |  |

| Papier zerreißen Beginnen Sie mit einem subtilen Zerreißgeräusch von Papier, das zerrissen wird... |  |  |  |  |

| Nähmaschinen benutzen Erzeugen Sie Umgebungsgeräusche eines Nähzimmers mit gleichmäßigem Nähmaschinensummen... |  |  |  |  |

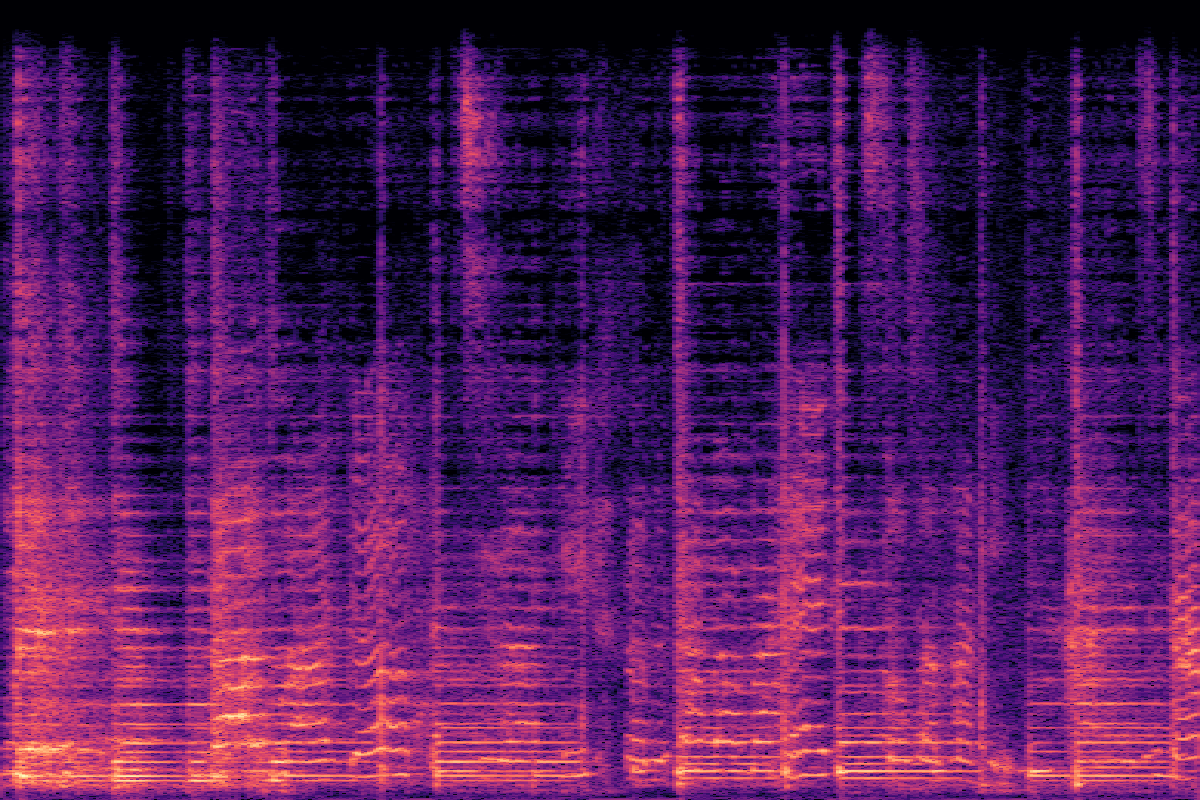

V2A-Vergleiche auf MovieGen Audio (Out-of-Distribution)

Sehen Sie, wie ThinkSound bei anspruchsvollen, nicht zur Verteilung gehörenden Filmclips abschneidet.

| CoT | ThinkSound | Movie Gen Audio | MMAudio |

|---|---|---|---|

| Sanfte Saugeräusche Weicher, gleichmäßiger Hintergrund von leichtem Schnullersaugen... |  |  |  |

| Harmonische Saiten Akustikgitarrensaiten summen und brummen... |  |  |  |

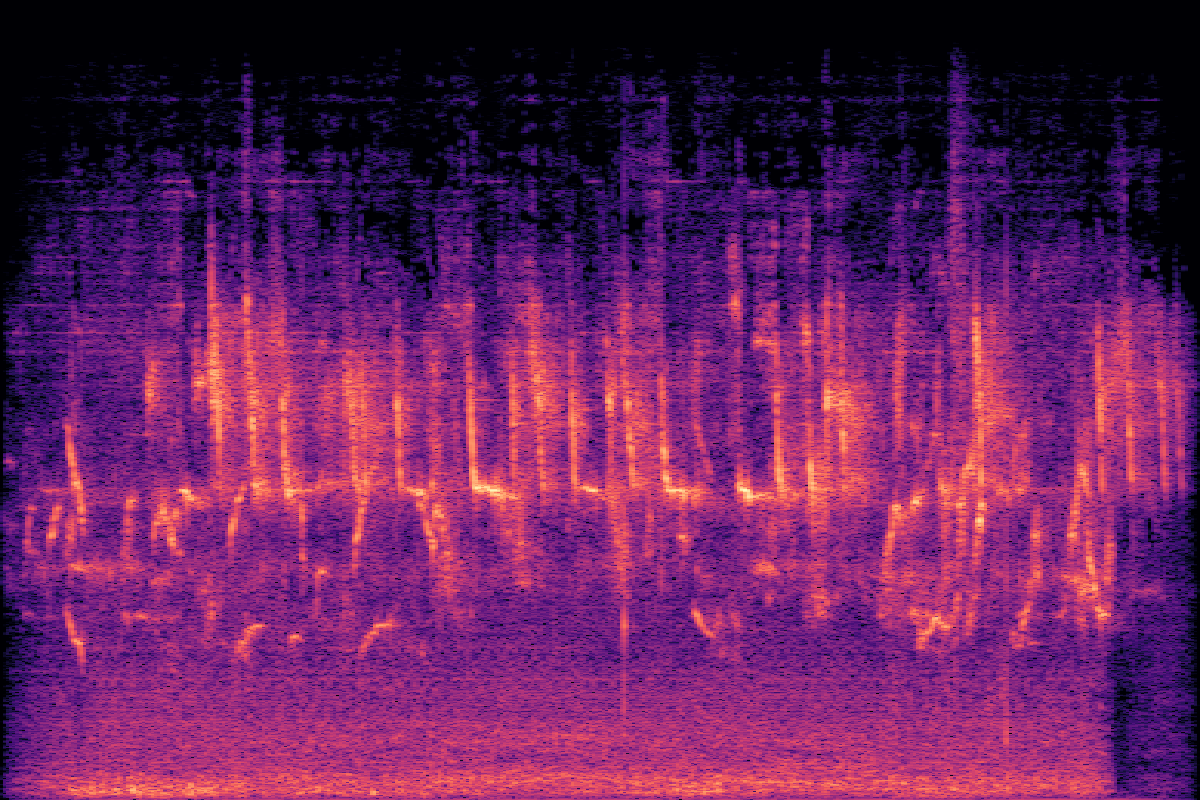

| Alter Fernseher summt Umgebungsgeräusche mit schwachem Rauschen und weißem Rauschen... |  |  |  |

| Intensiver Donner Ein leises Windsummen und gelegentliches Knistern tragen zur stürmischen Atmosphäre bei... |  |  |  |

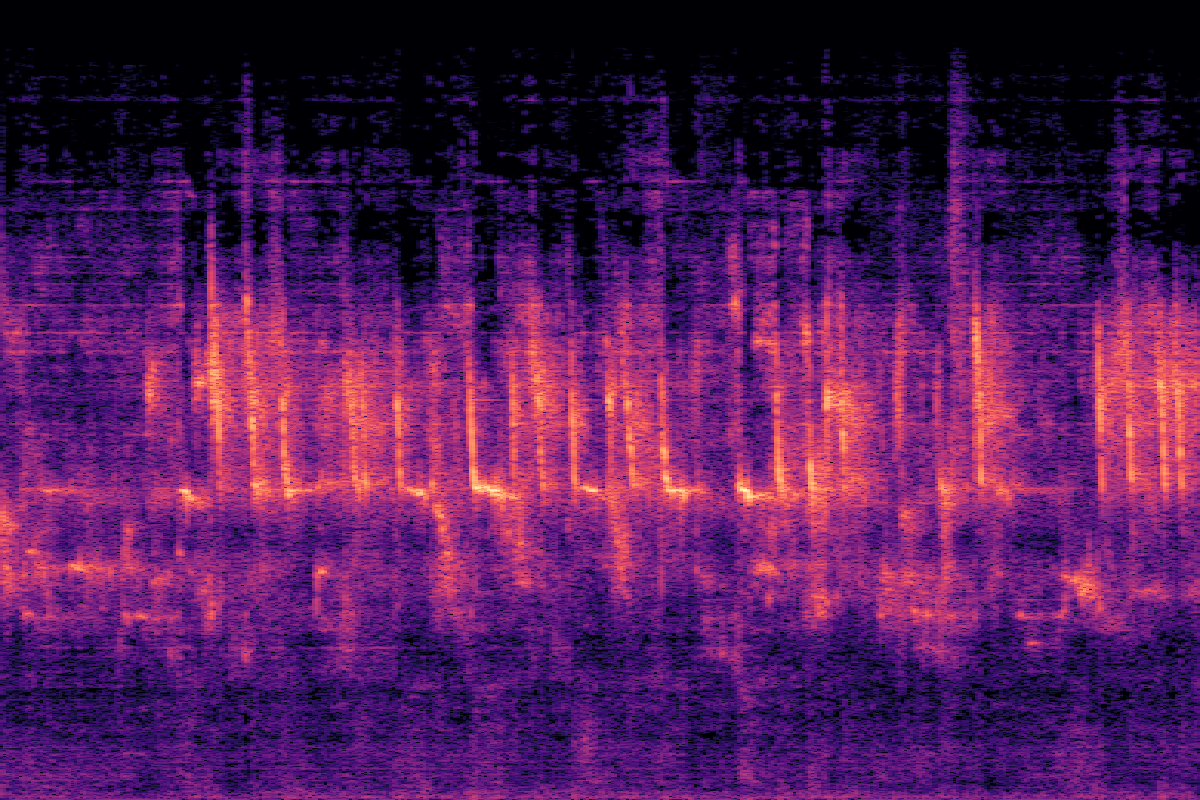

Interaktive Schritt-für-Schritt-Foley-Erstellung

V2A-Gen → Objektfokus → Audio-Inpainting

V2A-Gen → Objektfokus → Audiobearbeitung

Experimente

Hauptergebnisse auf VGGSound

ThinkSound übertrifft alle Baselines in den meisten objektiven Metriken und allen subjektiven Metriken und erzielt erhebliche Verbesserungen bei der Audioqualität und der semantischen Ausrichtung.

| Method | Objective Metrics | Subjective Metrics | Efficiency | |||||||

|---|---|---|---|---|---|---|---|---|---|---|

| FD ↓ | KLPaSST ↓ | KLPaNNs ↓ | DeSync ↓ | CLAPcap ↑ | CLAPCoT ↑ | MOS-Q ↑ | MOS-A ↑ | Params | Time(s) ↓ | |

| GT | - | - | - | 0.55 | 0.28 | 0.45 | 4.37±0.21 | 4.56±0.19 | - | - |

| See&Hear | 118.95 | 2.26 | 2.30 | 1.20 | 0.32 | 0.35 | 2.75±1.08 | 2.87±0.99 | 415M | 19.42 |

| V-AURA† | 46.99 | 2.23 | 1.83 | 0.65 | 0.23 | 0.37 | 3.42±1.03 | 3.20±1.17 | 695M | 14.00 |

| FoleyCrafter | 39.15 | 2.06 | 1.89 | 1.21 | 0.41 | 0.34 | 3.08±1.21 | 2.63±0.88 | 1.20B | 3.84 |

| Frieren† | 74.96 | 2.55 | 2.64 | 1.00 | 0.37 | 0.34 | 3.27±1.11 | 2.95±1.09 | 159M | - |

| V2A-Mapper† | 48.10 | 2.50 | 2.34 | 1.23 | 0.38 | 0.32 | 3.31±1.02 | 3.16±1.04 | 229M | - |

| MMAudio | 43.26 | 1.65 | 1.40 | 0.44 | 0.31 | 0.40 | 3.84±0.89 | 3.97±0.82 | 1.03B | 3.01 |

| ThinkSound | 34.56 | 1.52 | 1.32 | 0.46 | 0.33 | 0.46 | 4.02±0.73 | 4.18±0.79 | 1.30B | 1.07 |

| w/o CoT Reasoning | 39.84 | 1.59 | 1.40 | 0.48 | 0.29 | 0.41 | 3.91±0.83 | 4.04±0.75 | 1.30B | 0.98 |

Ablationsstudien

Wir haben den Beitrag jeder Komponente untersucht, um die Wirksamkeit unserer Designentscheidungen zu validieren, wobei wir uns auf die Textkodierung und die multimodale Integration konzentriert haben.

Textkodierungsstrategien

| Method | FD ↓ | KLPaSST ↓ | KLPaNNs ↓ | DeSync ↓ | CLAP ↑ |

|---|---|---|---|---|---|

| CLIP | 39.84 | 1.59 | 1.40 | 0.48 | 0.41 |

| T5 (CoT) | 37.65 | 1.54 | 1.35 | 0.46 | 0.44 |

| CLIP + T5 | 34.56 | 1.52 | 1.32 | 0.46 | 0.46 |

Multimodale Integration

| Integration | FD ↓ | KLPaSST ↓ | KLPaNNs ↓ | DeSync ↓ | CLAP ↑ |

|---|---|---|---|---|---|

| audio only | 37.13 | 1.58 | 1.37 | 0.50 | 0.43 |

| linear video | 38.96 | 1.58 | 1.38 | 0.46 | 0.45 |

| gated video | 34.56 | 1.52 | 1.32 | 0.46 | 0.46 |

Auswirkungen der Modellgröße

| Size | FD ↓ | KLPaSST ↓ | KLPaNNs ↓ | DeSync ↓ | CLAPCoT ↑ |

|---|---|---|---|---|---|

| Small | 40.80 | 1.64 | 1.38 | 0.46 | 0.41 |

| Medium | 36.80 | 1.56 | 1.34 | 0.46 | 0.44 |

| Large | 34.56 | 1.52 | 1.32 | 0.46 | 0.46 |

Häufig gestellte Fragen

ThinkSound ist ein fortschrittliches KI-Framework, das zur Erzeugung und Bearbeitung von Audio für Videos entwickelt wurde. Im Gegensatz zu herkömmlichen Modellen verwendet es einen Denkprozess namens Chain-of-Thought (CoT), um den Kontext eines Videos zu verstehen und hochrelevanten, hochwertigen Sound zu erstellen, ähnlich wie es ein professioneller Sounddesigner tun würde.

Chain-of-Thought ermöglicht es dem Modell, eine komplexe Aufgabe (wie "Erstelle einen Soundtrack für dieses Video") in kleinere, logische Schritte zu zerlegen. Zum Beispiel könnte es zuerst die Hauptobjekte und -aktionen identifizieren, dann über die Akustik der Umgebung nachdenken und schließlich über die geeigneten Geräusche und deren Timing entscheiden. Dieser schrittweise Prozess führt zu einer genaueren und kontextbewussteren Audiogenerierung.

Drei Hauptpunkte: 1) Die Verwendung von CoT-Reasoning für eine intelligentere Klangerzeugung. 2) Seine Interaktivität, die es Benutzern ermöglicht, Audio zu bearbeiten, sich auf bestimmte Objekte zu konzentrieren und den Klang mit natürlicher Sprache zu verfeinern. 3) Es wird von AudioCoT angetrieben, einem einzigartigen Datensatz, der speziell für das Training dieser Art von auf Schlussfolgerungen basierender Audiogenerierung entwickelt wurde.

Ja! Wir haben eine interaktive Demo auf Hugging Face Spaces bereitgestellt, die oben auf dieser Seite verlinkt ist. Sie können auch den Quellcode auf GitHub erkunden, um das Modell selbst auszuführen.