ThinkSound

Pionnier de la génération et de l'édition audio avec le raisonnement en chaîne de pensée

Résumé

Bien que l'IA moderne ait fait de grands progrès dans la génération d'audio à partir de vidéos,

la création d'un son haute-fidélité qui correspond vraiment à la nuance du contenu visuel

reste un obstacle majeur. La conception sonore professionnelle nécessite

un raisonnement complexe sur les indices visuels, l'acoustique et le timing - une compétence qui

a été difficile à reproduire en IA.

Cet article présente ThinkSound, un cadre révolutionnaire

qui apprend à l'IA à "penser" comme un concepteur sonore. En utilisant le raisonnement

en chaîne de pensée (CoT), ThinkSound décompose la tâche complexe

de la génération audio en étapes logiques et gérables. Cela permet

non seulement de créer du son à partir de zéro, mais aussi d'effectuer des modifications et des affinements interactifs,

axés sur les objets, à l'aide de simples commandes en langage naturel. Pour ce faire,

nous présentons également AudioCoT, un ensemble de données unique en son genre,

conçu pour entraîner les modèles à ce processus de raisonnement. Nos expériences montrent

que ThinkSound établit un nouvel état de l'art en matière de qualité et de pertinence audio,

avec des performances exceptionnelles même sur des scènes de films complexes et hors distribution.

Synergie avec les modèles de génération de vidéos

ThinkSound ajoute de manière transparente des paysages sonores riches et synchronisés aux vidéos créées par les principaux modèles génératifs. Les vidéos ci-dessous ont été générées par leurs modèles respectifs ; tout l'audio a été créé par ThinkSound.

Veo + ThinkSound

Sora + ThinkSound

MovieGen + ThinkSound

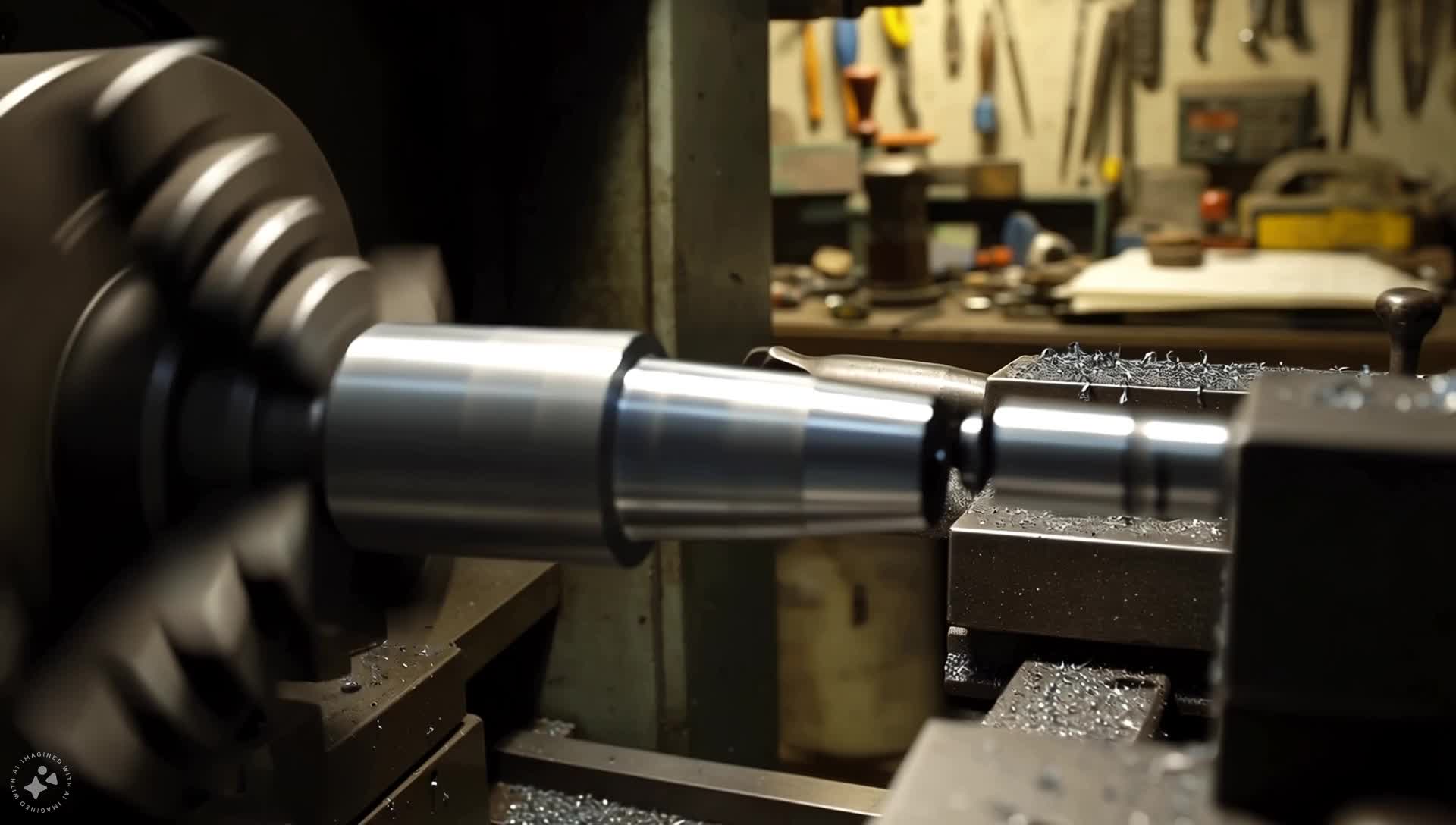

Comparaisons V2A sur VGGSound (en distribution)

Cliquez sur une miniature pour charger et lire la vidéo, en comparant ThinkSound à d'autres modèles.

| CoT | Vérité terrain | ThinkSound | MMAudio | See&Hear |

|---|---|---|---|---|

| Jouer au tennis Générer des sons de raquette de tennis frappant une balle et le rebond de la balle... |  |  |  |  |

| Impression d'imprimante Générer un son d'impression continu avec des bips périodiques... |  |  |  |  |

| Déchirer du papier Commencer par un son subtil de déchirement de papier... |  |  |  |  |

| Utilisation de machines à coudre Générer des sons d'ambiance de salle de couture avec un bourdonnement constant de machine à coudre... |  |  |  |  |

Comparaisons V2A sur MovieGen Audio (hors distribution)

Découvrez les performances de ThinkSound sur des extraits de films difficiles et hors distribution.

| CoT | ThinkSound | Movie Gen Audio | MMAudio |

|---|---|---|---|

| Doux bruits de succion Fond sonore doux et régulier de succion de tétine légère... |  |  |  |

| Cordes harmonieuses Cordes de guitare acoustique qui bourdonnent et vrombissent... |  |  |  |

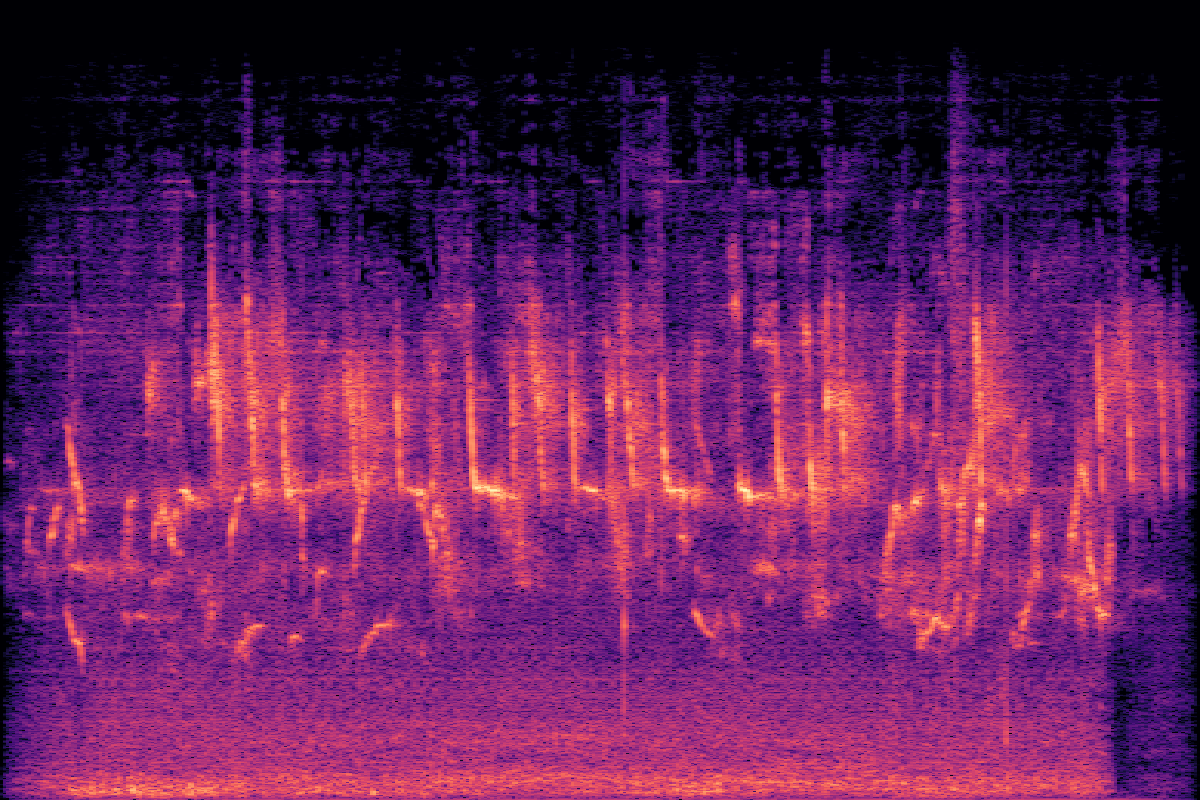

| Bourdonnement de vieille télévision Bruit de fond ambiant avec de légers parasites et un bruit blanc... |  |  |  |

| Tonnerre intense Un faible bourdonnement de vent et des craquements occasionnels ajoutent à l'atmosphère orageuse... |  |  |  |

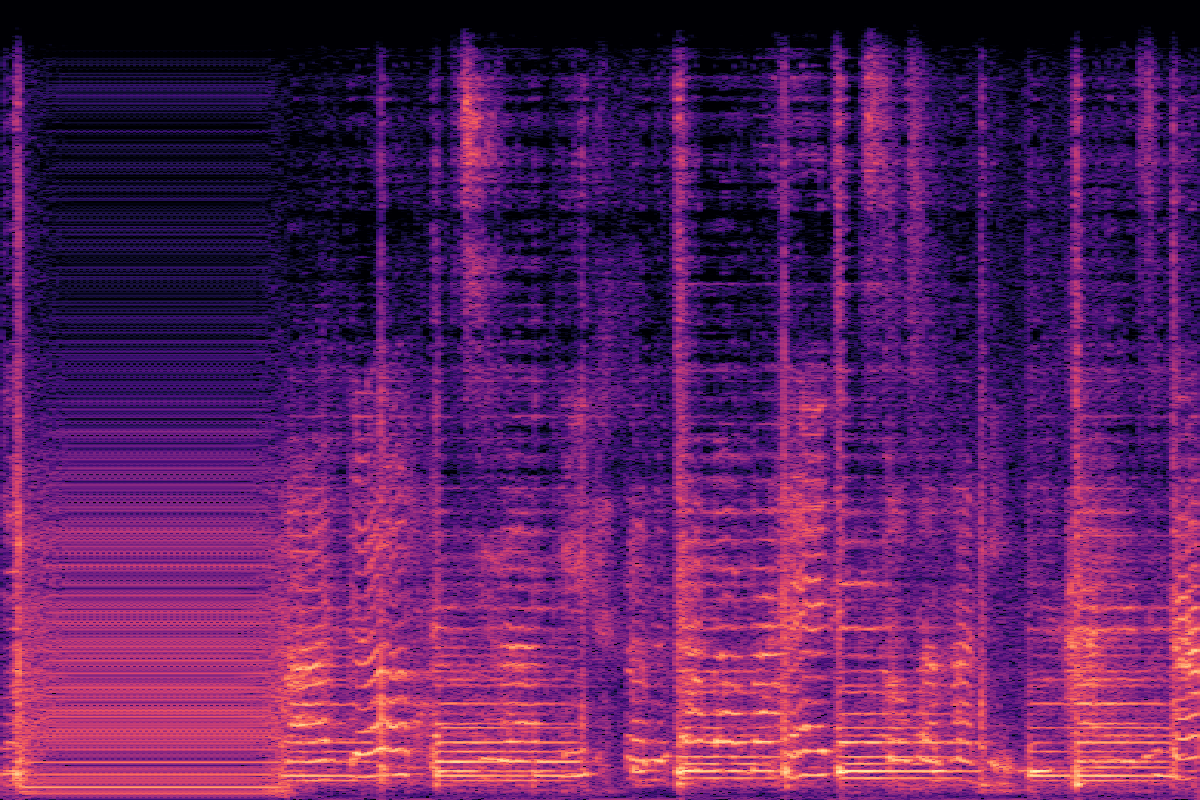

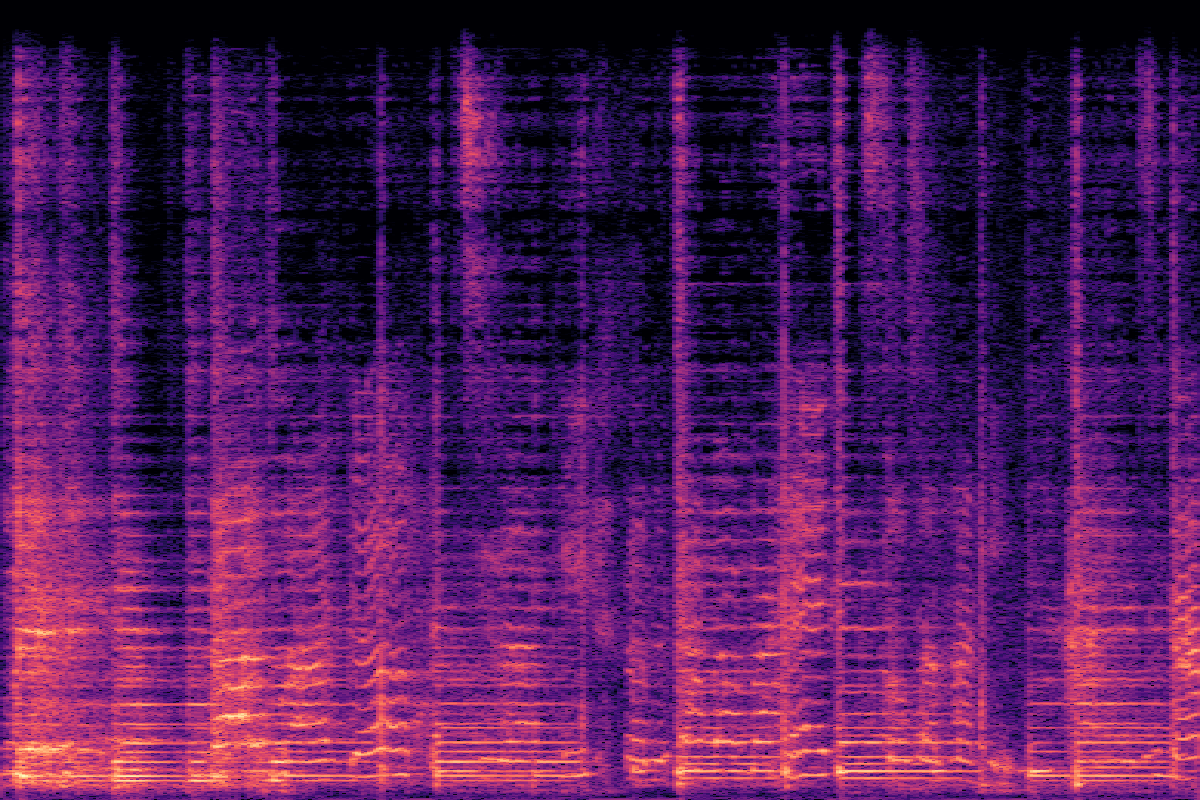

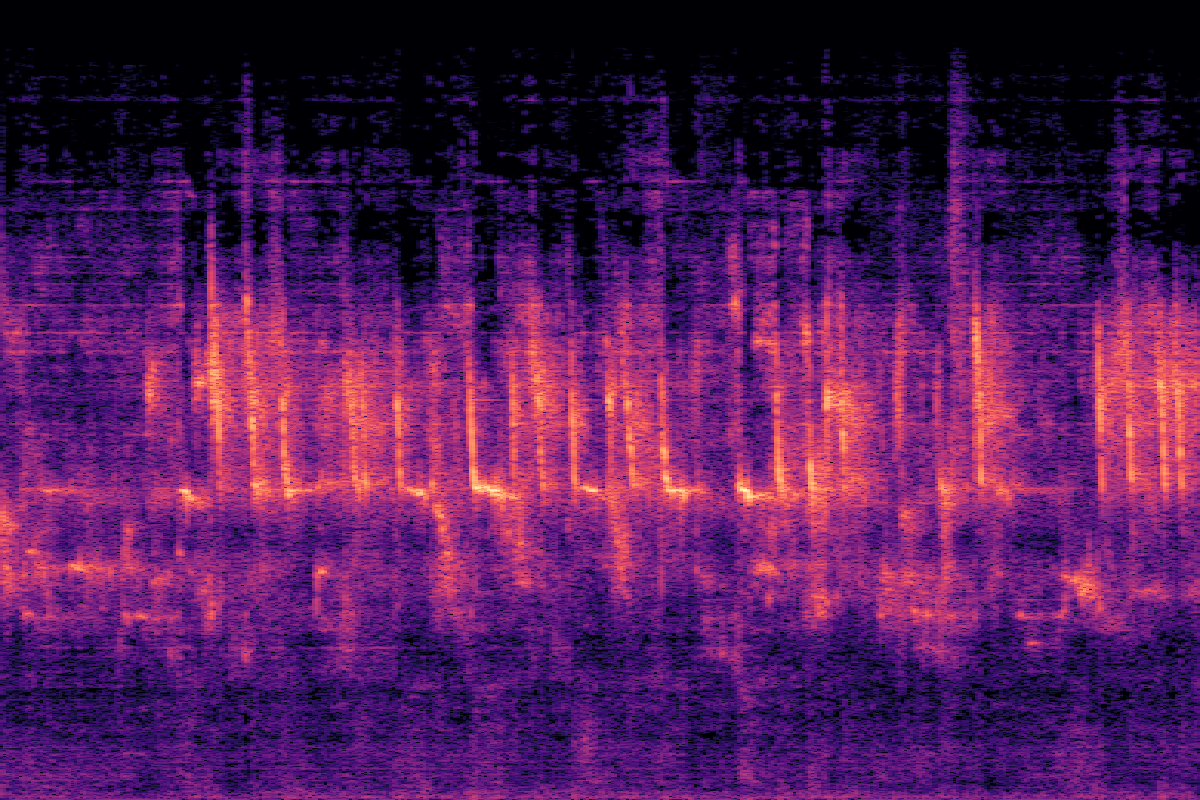

Création interactive de bruitage étape par étape

Génération V2A → Focus sur l'objet → Inpainting audio

Génération V2A → Focus sur l'objet → Édition audio

Expériences

Principaux résultats sur VGGSound

ThinkSound surpasse toutes les lignes de base sur la plupart des métriques objectives et toutes les métriques subjectives, réalisant des améliorations substantielles de la qualité audio et de l'alignement sémantique.

| Method | Objective Metrics | Subjective Metrics | Efficiency | |||||||

|---|---|---|---|---|---|---|---|---|---|---|

| FD ↓ | KLPaSST ↓ | KLPaNNs ↓ | DeSync ↓ | CLAPcap ↑ | CLAPCoT ↑ | MOS-Q ↑ | MOS-A ↑ | Params | Time(s) ↓ | |

| GT | - | - | - | 0.55 | 0.28 | 0.45 | 4.37±0.21 | 4.56±0.19 | - | - |

| See&Hear | 118.95 | 2.26 | 2.30 | 1.20 | 0.32 | 0.35 | 2.75±1.08 | 2.87±0.99 | 415M | 19.42 |

| V-AURA† | 46.99 | 2.23 | 1.83 | 0.65 | 0.23 | 0.37 | 3.42±1.03 | 3.20±1.17 | 695M | 14.00 |

| FoleyCrafter | 39.15 | 2.06 | 1.89 | 1.21 | 0.41 | 0.34 | 3.08±1.21 | 2.63±0.88 | 1.20B | 3.84 |

| Frieren† | 74.96 | 2.55 | 2.64 | 1.00 | 0.37 | 0.34 | 3.27±1.11 | 2.95±1.09 | 159M | - |

| V2A-Mapper† | 48.10 | 2.50 | 2.34 | 1.23 | 0.38 | 0.32 | 3.31±1.02 | 3.16±1.04 | 229M | - |

| MMAudio | 43.26 | 1.65 | 1.40 | 0.44 | 0.31 | 0.40 | 3.84±0.89 | 3.97±0.82 | 1.03B | 3.01 |

| ThinkSound | 34.56 | 1.52 | 1.32 | 0.46 | 0.33 | 0.46 | 4.02±0.73 | 4.18±0.79 | 1.30B | 1.07 |

| w/o CoT Reasoning | 39.84 | 1.59 | 1.40 | 0.48 | 0.29 | 0.41 | 3.91±0.83 | 4.04±0.75 | 1.30B | 0.98 |

Études d'ablation

Nous avons étudié la contribution de chaque composant pour valider l'efficacité de nos choix de conception, en nous concentrant sur l'encodage de texte et l'intégration multimodale.

Stratégies d'encodage de texte

| Method | FD ↓ | KLPaSST ↓ | KLPaNNs ↓ | DeSync ↓ | CLAP ↑ |

|---|---|---|---|---|---|

| CLIP | 39.84 | 1.59 | 1.40 | 0.48 | 0.41 |

| T5 (CoT) | 37.65 | 1.54 | 1.35 | 0.46 | 0.44 |

| CLIP + T5 | 34.56 | 1.52 | 1.32 | 0.46 | 0.46 |

Intégration multimodale

| Integration | FD ↓ | KLPaSST ↓ | KLPaNNs ↓ | DeSync ↓ | CLAP ↑ |

|---|---|---|---|---|---|

| audio only | 37.13 | 1.58 | 1.37 | 0.50 | 0.43 |

| linear video | 38.96 | 1.58 | 1.38 | 0.46 | 0.45 |

| gated video | 34.56 | 1.52 | 1.32 | 0.46 | 0.46 |

Impact de la taille du modèle

| Size | FD ↓ | KLPaSST ↓ | KLPaNNs ↓ | DeSync ↓ | CLAPCoT ↑ |

|---|---|---|---|---|---|

| Small | 40.80 | 1.64 | 1.38 | 0.46 | 0.41 |

| Medium | 36.80 | 1.56 | 1.34 | 0.46 | 0.44 |

| Large | 34.56 | 1.52 | 1.32 | 0.46 | 0.46 |

Questions fréquemment posées

ThinkSound est un cadre d'IA avancé conçu pour générer et éditer de l'audio pour les vidéos. Contrairement aux modèles traditionnels, il utilise un processus de raisonnement appelé Chaîne de Pensée (CoT) pour comprendre le contexte d'une vidéo et créer un son de haute qualité et très pertinent, un peu comme le ferait un concepteur sonore professionnel.

La Chaîne de Pensée permet au modèle de décomposer une tâche complexe (comme "créer une bande-son pour cette vidéo") en étapes plus petites et logiques. Par exemple, il peut d'abord identifier les principaux objets et actions, puis raisonner sur l'acoustique de l'environnement, et enfin décider des sons appropriés et de leur synchronisation. Ce processus étape par étape conduit à une génération audio plus précise et plus consciente du contexte.

Trois choses principales : 1) Son utilisation du raisonnement CoT pour une création sonore plus intelligente. 2) Son interactivité, permettant aux utilisateurs d'éditer l'audio, de se concentrer sur des objets spécifiques et d'affiner le son à l'aide du langage naturel. 3) Il est alimenté par AudioCoT, un ensemble de données unique conçu spécifiquement pour entraîner ce type de génération audio basée sur le raisonnement.

Oui ! Nous avons fourni une démo interactive sur Hugging Face Spaces, accessible en lien en haut de cette page. Vous pouvez également explorer le code source sur GitHub pour exécuter le modèle vous-même.